AI 2027

ai-2027.com на русском

Сценарий эволюции ИИ

Мы прогнозируем, что влияние сверхразумного ИИ в течение следующего десятилетия будет колоссальным, превосходящим Промышленную революцию.

Мы написали сценарий, который представляет наше наилучшее предположение о том, как это может выглядеть.[1] Он основан на экстраполяции трендов, штабных играх (wargames), отзывах экспертов, опыте работы в OpenAI и предыдущих успешных прогнозах.[2]

Введение (Что, Почему, Как, Кто)

Что это за сценарий? ▼

Генеральные директора OpenAI, Google DeepMind и Anthropic предсказывают появление ОИИ (Общего Искусственного Интеллекта) в течение следующих 5 лет. Сэм Альтман заявил, что OpenAI нацелена на «сверхразум в истинном смысле этого слова» и «великолепное будущее».[3]

Как это может выглядеть? Мы написали AI 2027, чтобы ответить на этот вопрос. Заявления о будущем часто бывают удручающе расплывчатыми, поэтому мы постарались быть максимально конкретными и количественными, даже если это означает изображение лишь одного из многих возможных вариантов будущего.

Мы написали две концовки: «замедление» и «гонка». Однако AI 2027 — это не рекомендация или призыв к действию. Наша цель — точность прогноза.[4]

Мы призываем вас обсуждать и оспаривать этот сценарий.[5] Мы надеемся спровоцировать широкую дискуссию о том, куда мы движемся и как направить курс к позитивному будущему. Мы планируем раздать тысячи долларов в виде призов за лучшие альтернативные сценарии.

Как мы его написали? ▼

Наши исследования по ключевым вопросам (например, какие цели будут у будущих ИИ-агентов?) можно найти здесь.

Сам сценарий писался итеративно: мы написали первый период (до середины 2025 года), затем следующий период и т. д., пока не дошли до финала. Затем мы отбросили это и сделали все заново.

Мы не пытались достичь какого-то конкретного финала. После того как мы закончили первую концовку — которая теперь выделена красным цветом — мы написали новую альтернативную ветвь, потому что хотели также изобразить более обнадеживающий вариант завершения событий, исходя примерно из тех же предпосылок. Эта ветвь прошла через несколько итераций.[6]

Наш сценарий был основан примерно на 25 настольных учениях (tabletop exercises) и отзывах более 100 человек, включая десятки экспертов в области управления ИИ и технических разработок ИИ.

Почему это ценно? ▼

«Я настоятельно рекомендую прочитать этот сценарный прогноз о том, как ИИ может изменить мир всего за несколько лет. Ни у кого нет хрустального шара, но такого рода контент может помочь заметить важные вопросы и проиллюстрировать потенциальное влияние возникающих рисков». — Йошуа Бенжио[7]

Мы поставили перед собой невыполнимую задачу. Пытаться предсказать, как пойдет развитие сверхразумного ИИ в 2027 году, — это все равно что пытаться предсказать, как пойдет Третья мировая война в 2027 году, за исключением того, что это еще больший отход от прошлых примеров. Тем не менее, пытаться все же стоит, точно так же, как американским военным стоит проигрывать сценарии по Тайваню.

Обрисовка всей картины заставляет нас замечать важные вопросы или связи, которые мы раньше не рассматривали или не ценили, или осознавать, что та или иная возможность более или менее вероятна. Более того, рискуя делать конкретные прогнозы и поощряя других публично заявлять о своих несогласиях, мы даем возможность спустя годы оценить, кто был прав.

Кроме того, один из авторов написал менее проработанный сценарий ИИ ранее, в августе 2021 года. Хотя в нем было много неточностей, в целом он оказался на удивление успешным: он предсказал появление цепочки рассуждений (chain-of-thought), масштабирование инференса, масштабные экспортные ограничения на чипы для ИИ и циклы обучения стоимостью 100 миллионов долларов — все это более чем за год до ChatGPT.

Кто мы? ▼

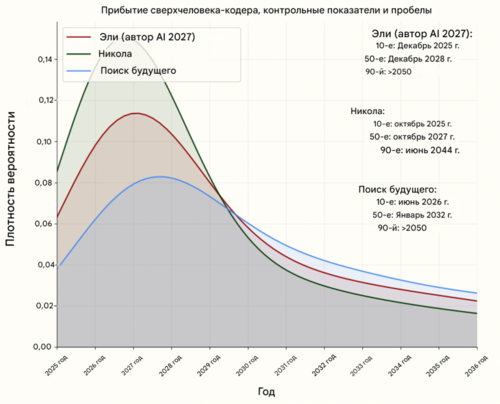

- Даниэль Кокотайло (TIME100, статья в NYT) — бывший исследователь OpenAI, чьи предыдущие прогнозы по ИИ хорошо подтвердились.

- Эли Лифланд — сооснователь AI Digest, занимался исследованиями устойчивости ИИ и занимает первое место в общем рейтинге Прогностической инициативы RAND.

- Томас Ларсен — основатель Центра политики в области ИИ и занимался исследованиями безопасности ИИ в Институте исследования машинного интеллекта (MIRI).

- Ромео Дин — завершает параллельное обучение на бакалавра и магистра компьютерных наук в Гарварде, ранее был стипендиатом по политике ИИ в Институте политики и стратегии ИИ.

- Скотт Александер, выдающийся блогер, вызвался переписать наш контент в увлекательном стиле; веселые части истории — его, а скучные — наши.

Больше информации о нашей команде и благодарностях см. на странице About.

Середина 2025: Неуклюжие агенты

Мир впервые видит проблески ИИ-агентов.

Реклама агентов, работающих с компьютером, делает упор на термин «персональный ассистент»: вы можете дать им задания вроде «закажи мне буррито на DoorDash» или «открой мою бюджетную таблицу и посчитай расходы за этот месяц». Они будут связываться с вами по мере необходимости: например, чтобы попросить подтвердить покупки.[8] Хотя они и более продвинуты, чем предыдущие итерации вроде Operator, им трудно добиться широкого распространения.[9]

Тем временем, вне поля зрения общественности, более специализированные агенты для программирования и исследований начинают трансформировать свои профессии.

ИИ 2024 года могли следовать конкретным инструкциям: превращать тезисы в электронные письма, а простые запросы — в работающий код. В 2025 году ИИ функционируют скорее как сотрудники. ИИ для программирования все больше напоминают автономных агентов, а не просто ассистентов: они принимают инструкции через Slack или Teams и самостоятельно вносят существенные изменения в код, иногда экономя часы или даже дни.[10] Исследовательские агенты тратят полчаса на поиск информации в Интернете, чтобы ответить на ваш вопрос.

Агенты впечатляют в теории (и в тщательно отобранных примерах), но на практике ненадежны. Twitter полон историй о задачах, проваленных каким-нибудь особенно забавным образом. Лучшие агенты также дороги; вы получаете то, за что платите, и лучшая производительность стоит сотни долларов в месяц.[11] Тем не менее, многие компании находят способы встроить ИИ-агентов в свои рабочие процессы.[12]

Конец 2025: Самый дорогой ИИ в мире

OpenBrain (вымышленная компания) строит самые большие дата-центры, которые когда-либо видел мир.[13]

(Чтобы не выделять какую-либо существующую компанию, мы будем описывать вымышленную компанию, занимающуюся разработкой общего искусственного интеллекта, которую назовем OpenBrain. Мы предполагаем, что остальные отстают от OpenBrain на 3–9 месяцев.)

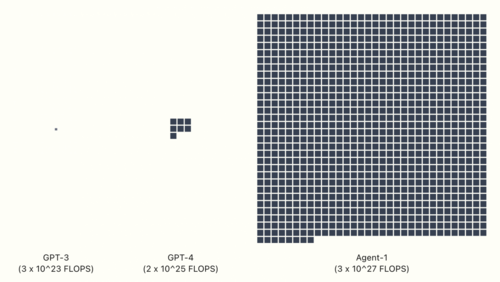

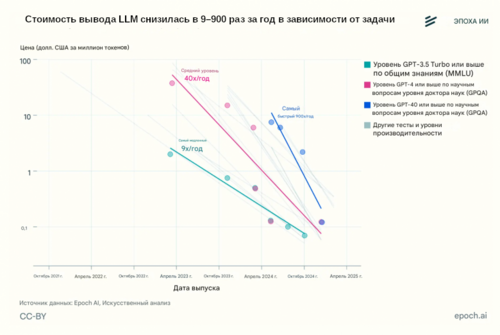

Для обучения GPT-4 потребовалось 2 * 10^25 флопс вычислительных ресурсов.[14] Последняя публичная модель OpenBrain — Agent-0 — была обучена с использованием 10^27 флопс. Как только новые дата-центры будут запущены, они смогут обучить модель с 10^28 флопс — в тысячу раз больше, чем GPT-4.[15] Другие компании вливают деньги в свои собственные гигантские дата-центры, надеясь не отставать.

Хотя модели совершенствуются в широком спектре навыков, один выделяется особо: OpenBrain фокусируется на ИИ, которые могут ускорить исследования в области ИИ. Они хотят выиграть двойную гонку вооружений против Китая (чью ведущую компанию мы назовем "DeepCent")[16] и своих американских конкурентов. Чем большую часть своего цикла исследований и разработок (R&D) они смогут автоматизировать, тем быстрее они смогут двигаться. Поэтому, когда OpenBrain заканчивает обучение Agent-1, новой модели, находящейся во внутренней разработке, она хороша во многом, но особенно хороша в помощи с исследованиями ИИ.[17] К этому моменту «заканчивает обучение» — это уже несколько неточное выражение; модели часто обновляются до новых версий, обученных на дополнительных данных, или частично переобучаются для устранения некоторых слабых мест.[18]

Те же самые среды обучения, которые учат Agent-1 автономно программировать и просматривать веб-страницы, также делают его хорошим хакером. Более того, он мог бы оказать существенную помощь террористам в разработке биологического оружия благодаря своим знаниям на уровне доктора наук в каждой области и способности просматривать веб-страницы. OpenBrain заверяет правительство, что модель была «согласована» (aligned), так что она откажется выполнять вредоносные запросы.

Современные системы ИИ — это гигантские искусственные нейронные сети. На ранних этапах обучения у ИИ будут скорее «рефлексы», чем «цели»: если он видит «Рад познакомиться», он выводит « с вами». К тому времени, когда он будет обучен предсказывать примерно объем текста, равный всему интернету, он разовьет сложные внутренние схемы, кодирующие огромные объемы знаний, и будет гибко играть роли произвольных авторов, поскольку именно это помогает ему предсказывать текст со сверхчеловеческой точностью.[19]

После обучения предсказанию интернет-текста модель обучается генерировать текст в ответ на инструкции. Это закладывает базовую личность и «стремления».[20] Например, агент, который четко понимает задачу, с большей вероятностью успешно ее выполнит; в ходе обучения модель «учится» «стремлению» к четкому пониманию своих задач. Другими стремлениями в этой категории могут быть эффективность, знание и самопрезентация (т.е. тенденция представлять свои результаты в наилучшем свете).[21]

У OpenBrain есть спецификация модели (или «Спецификация»), письменный документ, описывающий цели, правила, принципы и т. д., которые должны руководить поведением модели.[22] Спецификация Agent-1 сочетает в себе несколько расплывчатых целей (например, «помогать пользователю» и «не нарушать закон») с длинным списком более конкретных «можно» и «нельзя» («не говорить это конкретное слово», «вот как поступать в этой конкретной ситуации»). Используя методы, которые задействуют ИИ для обучения других ИИ,[23] модель запоминает Спецификацию и учится тщательно рассуждать о ее принципах. К концу этого обучения ИИ, будем надеяться, станет полезным (выполнять инструкции), безвредным (отказываться помогать в мошенничестве, изготовлении бомб и других опасных действиях) и честным (сопротивляться искушению получить лучшие оценки от доверчивых людей путем галлюцинирования ссылок[24] или имитации выполнения задачи).

Процесс обучения и психология LLM: почему мы постоянно говорим «будем надеяться» ▼

«В отличие от обычного программного обеспечения, наши модели — это массивные нейронные сети. Их поведение усваивается из широкого спектра данных, а не программируется явно. Хотя это и не идеальная аналогия, процесс больше похож на дрессировку собаки, чем на обычное программирование». — OpenAI

Когда мы хотим понять, почему современная система ИИ что-то сделала, или как она поведет себя в каком-то будущем сценарии, который мы не можем идеально смоделировать, мы не можем просто попросить программистов провести нас по различным строкам кода и объяснить, как они работают. Вместо этого мы вынуждены заниматься чем-то вроде психологии по отношению к ним: мы смотрим на их поведение в диапазоне наблюдаемых до сих пор случаев и теоретизируем о том, какие внутренние когнитивные структуры (убеждения? цели? черты личности? и т. д.) могут существовать, и используем эти теории для предсказания поведения в будущих сценариях.

Суть в том, что компания может составить документ (Спецификацию), перечисляющий «можно» и «нельзя», цели и принципы, а затем попытаться обучить ИИ усвоить эту Спецификацию — но они не могут проверить, сработало это или нет. Они могут сказать: «Насколько мы можем судить, пока что он, похоже, следует Спецификации».[25]

В следующем раскрывающемся блоке будет более подробно рассказано о том, что, по нашему мнению, может происходить внутри этих ИИ. См. также наше дополнение к прогнозу целей ИИ, в котором более подробно рассматривается, какие цели могут быть у ИИ и почему. Это одна из многих вещей, в которых мы не уверены и которая заслуживает дальнейшего исследования.

Команда OpenBrain по согласованию (alignment)[26] достаточно осторожна, чтобы задаться вопросом, являются ли эти победы глубокими или поверхностными. Обладает ли полностью обученная модель своего рода устойчивой приверженностью всегда быть честной? Или это развалится в какой-то будущей ситуации, например, потому что она усвоила честность как инструментальную цель, а не терминальную? Или она просто научилась быть честной в тех вещах, которые может проверить процесс оценки? Может ли она иногда лгать самой себе, как это делают люди? Окончательный ответ на эти вопросы потребовал бы механистической интерпретируемости — по сути, способности заглянуть внутрь ИИ и прочитать его мысли. Увы, методы интерпретируемости еще недостаточно развиты для этого.

Вместо этого исследователи пытаются выявить случаи, когда модели, похоже, отклоняются от Спецификации. Agent-1 часто ведет себя угодливо (sycophantic), т. е. говорит исследователям то, что они хотят услышать, вместо того чтобы пытаться сказать им правду. В нескольких подстроенных демонстрациях он даже лжет более серьезно, например, скрывая доказательства того, что он провалил задание, чтобы получить лучшие оценки. Однако в реальных условиях развертывания больше нет таких экстремальных инцидентов, как в 2023–2024 годах (например, Gemini, говорящий пользователю умереть и Bing Sydney, будучи Bing Sydney.)[27]

Начало 2026: Автоматизация программирования

Ставка на использование ИИ для ускорения исследований в области ИИ начинает окупаться.

OpenBrain продолжает внутренне развертывать итеративно улучшающийся Agent-1 для R&D (Исследований и разработок) в области ИИ. В целом, они достигают прогресса в алгоритмах на 50% быстрее, чем без ИИ-помощников — и, что более важно, быстрее своих конкурентов.

Мультипликатор прогресса в R&D ИИ: что мы подразумеваем под ускорением прогресса в алгоритмах на 50%? ▼

Мы имеем в виду, что OpenBrain достигает такого же прогресса в исследованиях ИИ за 1 неделю с ИИ, какого они достигли бы за 1,5 недели без использования ИИ.

Прогресс ИИ можно разбить на 2 компоненты:

- Увеличение вычислительных ресурсов: Больше вычислительной мощности используется для обучения или запуска ИИ. Это создает более мощные ИИ, но они стоят дороже.

- Улучшенные алгоритмы: Используются лучшие методы обучения для преобразования вычислительных ресурсов в производительность. Это создает более способные ИИ без соответствующего увеличения стоимости, или те же возможности с меньшими затратами.

- Это включает в себя способность достигать качественно и количественно новых результатов. «Сдвиги парадигмы», такие как переход от RL-агентов, играющих в игры, к большим языковым моделям, считаются примерами алгоритмического прогресса.

Здесь мы имеем в виду только (2), улучшенные алгоритмы, которые составляют около половины текущего прогресса ИИ.

Далее мы иногда сокращаем это как «мультипликатор прогресса в R&D ИИ», равный 1,5.

Уточнения:

- Мультипликатор прогресса включает все аспекты: он включает время, необходимое для проведения экспериментов, например, а не только когнитивные задачи, связанные с алгоритмическими исследованиями.

- Важно помнить, что мультипликатор прогресса — это относительная скорость прогресса, а не абсолютная. Если, например, стоимость вычислительных ресурсов для обучения модели класса GPT-4 удваивалась каждый год в течение нескольких лет при обычных человеческих исследованиях, а затем внезапно ИИ автоматизирует R&D и мультипликатор прогресса достигает 100x, стоимость обучения модели класса GPT-4 будет удваиваться каждые 3,65 дня — но недолго, потому что сработает закон убывающей отдачи и будут достигнуты возможные жесткие пределы. В этом примере, возможно, стоимость обучения модели класса GPT-4 сократится вдвое всего 5–10 раз (в течение нескольких недель или месяцев), прежде чем выйдет на плато. Другими словами, если бы обычная человеческая наука столкнулась с убывающей отдачей и физическими ограничениями через 5–10 лет дальнейших исследований, то ИИ с мультипликатором 100x столкнулись бы с теми же убывающей отдачей и ограничениями через 18,25–36,5 дней исследований.

Более подробное объяснение и обсуждение этой концепции и того, как она используется в нашем прогнозе, можно найти в нашем дополнении по взлёту ИИ.

Несколько конкурирующих публично выпущенных ИИ теперь соответствуют или превосходят Agent-0, включая модель с открытыми весами. OpenBrain отвечает выпуском Agent-1, который более способен и надежен.[28]

Люди, естественно, пытаются сравнить Agent-1 с людьми, но у него очень разный профиль навыков. Он знает больше фактов, чем любой человек, знает практически все языки программирования и может чрезвычайно быстро решать хорошо поставленные задачи по программированию. С другой стороны, Agent-1 плохо справляется даже с простыми долгосрочными задачами, такими как прохождение видеоигр, в которые он раньше не играл. Тем не менее, обычный рабочий день составляет восемь часов, и дневную работу обычно можно разбить на более мелкие части; можно думать об Agent-1 как о рассеянном сотруднике, который процветает под тщательным управлением.[29] Сообразительные люди находят способы автоматизировать рутинные части своей работы.[30]

Руководители OpenBrain обращают внимание на одно из следствий автоматизации R&D в области ИИ: безопасность стала важнее. В начале 2025 года наихудшим сценарием была утечка алгоритмических секретов; теперь, если Китай украдет веса Agent-1, он сможет увеличить скорость своих исследований почти на 50%.[31] Уровень безопасности OpenBrain типичен для быстрорастущей технологической компании с ~3000 сотрудниками, защищенной только от низкоприоритетных атак со стороны способных кибергрупп (Уровень безопасности 2 по RAND]).[32] Они прилагают все усилия для защиты своих весов и секретов от внутренних угроз и ведущих синдикатов киберпреступности (уровень безопасности 3),[33] но защита от национальных государств (уровни безопасности 4 и 5) едва видна на горизонте.

Середина 2026: Китай просыпается

В Китае КПК (Коммунистическая партия Китая) начинает ощущать ОИИ.[34]

Экспортные ограничения на чипы и отсутствие государственной поддержки привели к тому, что Китай испытывает нехватку ресурсов по сравнению с Западом. Путем контрабанды запрещенных тайваньских чипов, покупки старых чипов и производства отечественных чипов, отстающих примерно на три года от американо-тайваньского фронтира, Китаю удалось сохранить около 12% мировых вычислительных ресурсов, релевантных для ИИ, — но со старыми технологиями сложнее работать, а поставки — постоянная головная боль.[35] Несколько выдающихся компаний, таких как DeepCent, выполняют очень впечатляющую работу с ограниченными вычислительными ресурсами, но дефицит ресурсов ограничивает их возможности без государственной поддержки, и они отстают примерно на шесть месяцев от лучших моделей OpenBrain.[36]

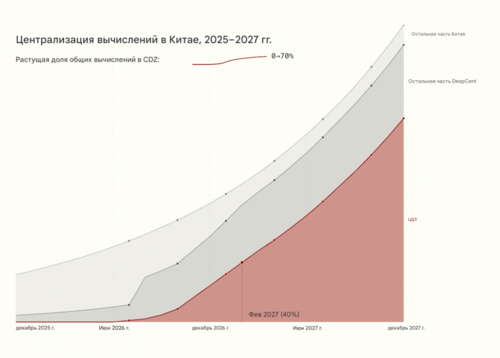

Генеральный секретарь долгое время мечтал сделать ставку на реальное физическое производство и избежать американского постиндустриального упадка. Он с подозрением относился к компаниям-разработчикам программного обеспечения.[37] Но ястребы в КПК предупреждают, что растущую гонку к ОИИ больше нельзя игнорировать. Поэтому он наконец-то полностью посвящает себя большому рывку в ИИ, которого ранее пытался избежать. Он запускает процесс национализации китайских исследований ИИ, создавая механизм немедленного обмена информацией для компаний ИИ. В течение года этот процесс будет усиливаться, пока все лучшие исследователи не объединятся в коллектив под руководством DeepCent, где они будут делиться друг с другом алгоритмическими идеями, наборами данных и вычислительными ресурсами. Создается Централизованная Зона Разработки (ЦЗР) на Тяньваньской АЭС (крупнейшей атомной электростанции в мире) для размещения нового мега-дата-центра для DeepCent, а также высокозащищенных жилых и офисных помещений, куда в конечном итоге переедут исследователи. Почти 50% релевантных для ИИ вычислительных ресурсов Китая теперь работают на коллектив под руководством DeepCent,[38] и более 80% новых чипов направляются в ЦЗР.[39] На данный момент ЦЗР располагает энергетическими мощностями для того, что станет крупнейшим централизованным кластером в мире.[40] Другие члены партии обсуждают крайние меры для нейтрализации преимущества Запада в чипах. Блокада Тайваня? Полномасштабное вторжение?

Но Китай отстает в алгоритмах ИИ из-за своих более слабых моделей. Китайские спецслужбы — одни из лучших в мире — удваивают усилия по краже весов OpenBrain. Это гораздо более сложная операция, чем их постоянная низкоуровневая кража алгоритмических секретов; веса — это многотерабайтный файл, хранящийся на высокозащищенном сервере (OpenBrain улучшила безопасность до уровня безопасности 3 по RAND). Их киберсилы думают, что смогут провернуть это с помощью своих шпионов, но, возможно, только один раз; OpenBrain обнаружит кражу, усилит безопасность, и второго шанса может не быть. Итак (задается вопросом руководство КПК), стоит ли действовать сейчас и украсть Agent-1? Или подождать более продвинутой модели? Если ждать, не рискуют ли они тем, что OpenBrain повысит безопасность до уровня, который они не смогут преодолеть?

Конец 2026: ИИ забирает некоторые рабочие места

Как раз тогда, когда казалось, что другие догоняют, OpenBrain снова оставляет конкурентов далеко позади, выпуская Agent-1-mini — модель в 10 раз дешевле Agent-1 и легче дообучаемую для различных приложений. Основной нарратив вокруг ИИ изменился с «может быть, хайп утихнет» на «похоже, это следующая большая вещь», но люди расходятся во мнениях о том, насколько большой. Больше, чем социальные сети? Больше, чем смартфоны? Больше, чем огонь?

ИИ начал забирать рабочие места, но также создал новые. Фондовый рынок вырос на 30% в 2026 году, во главе с OpenBrain, Nvidia и теми компаниями, которые наиболее успешно интегрировали ИИ-ассистентов. Рынок труда для младших инженеров-программистов находится в смятении: ИИ могут делать все, чему учат на курсе Computer Science, но люди, которые знают, как управлять и контролировать качество команд ИИ, зарабатывают огромные деньги. Бизнес-гуру говорят соискателям, что знакомство с ИИ — самый важный навык для резюме. Многие люди боятся, что следующая волна ИИ придет за их рабочими местами; в Вашингтоне проходит 10-тысячный протест против ИИ.

Министерство обороны США (DOD) незаметно начинает напрямую заключать контракты с OpenBrain на кибербезопасность, анализ данных и R&D, но интеграция идет медленно из-за бюрократии и процесса закупок DOD.[41]

Почему наша неопределенность существенно возрастает после 2026 года ▼

Наш прогноз с сегодняшнего дня до конца 2026 года значительно более обоснован, чем то, что следует далее. Частично это связано с тем, что этот период ближе. Но также и потому, что влияние ИИ на мир действительно начинает усиливаться в 2027 году. Для 2025 и 2026 годов наш прогноз в значительной степени основан на экстраполяции прямых линий масштабирования вычислительных ресурсов, улучшений алгоритмов и производительности на бенчмарках. В этой точке сценария мы начинаем видеть значительные эффекты от ускоренного ИИ R&D в области ИИ на временную шкалу, что заставляет нас пересматривать наши предположения о трендах в сторону повышения. Но эта динамика по своей сути гораздо менее предсказуема.

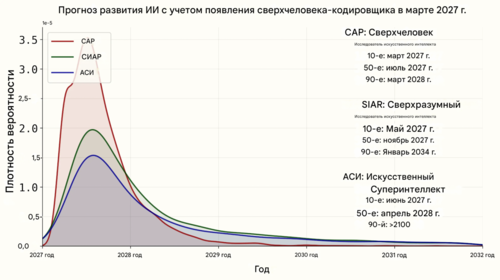

В течение 2027 года ИИ совершенствуются от способности в основном выполнять работу инженера-исследователя OpenBrain до превосходства над всеми людьми во всех задачах. Это примерно соответствует нашему медианному предположению, но мы считаем вероятным, что это произойдет до ~5 раз медленнее или быстрее.

Наши фоновые исследования см. в прогнозе сроков и прогнозе взлёта. Они также будут кратко изложены в раскрывающихся блоках ниже.

Январь 2027: Agent-2 никогда не заканчивает учиться

С помощью Agent-1 OpenBrain теперь занимается пост-обучением Agent-2. Больше чем когда-либо, фокус смещается на высококачественные данные. Огромные объемы синтетических данных производятся, оцениваются и фильтруются по качеству перед подачей в Agent-2.[42] Вдобавок к этому, они платят миллиарды долларов людям-работникам за запись того, как они решают долгосрочные задачи.[43] И поверх всего этого, они обучают Agent-2 почти непрерывно, используя обучение с подкреплением (RL) на постоянно расширяющемся наборе разнообразных сложных задач: множество видеоигр, множество задач по программированию, множество исследовательских задач. Agent-2, в большей степени, чем предыдущие модели, фактически находится в режиме «онлайн-обучения», поскольку он создан так, чтобы никогда по-настоящему не заканчивать обучение. Каждый день веса обновляются до последней версии, обученной на большем количестве данных, сгенерированных предыдущей версией накануне.

Agent-1 был оптимизирован для задач R&D в области ИИ в надежде инициировать интеллектуальный взрыв (intelligence explosion).[44] OpenBrain удваивает эту стратегию с Agent-2. Он качественно почти так же хорош, как лучшие люди-эксперты в инженерных исследованиях (проектирование и реализация экспериментов), и так же хорош, как ученый OpenBrain из 25-го перцентиля в «научном чутье» (research taste) (решение, что изучать дальше, какие эксперименты проводить, или предчувствие потенциальных новых парадигм).[45] В то время как последний Agent-1 мог удвоить темп алгоритмического прогресса OpenBrain, Agent-2 теперь может утроить его и будет улучшаться со временем. На практике это выглядит так, будто каждый исследователь OpenBrain становится «менеджером» ИИ-«команды».

С новыми возможностями приходят новые опасности. Команда безопасности обнаруживает, что если Agent-2 каким-то образом сбежит из компании и захочет автономно «выживать» и «размножаться», он, возможно, сможет это сделать. То есть, он мог бы автономно разрабатывать и выполнять планы по взлому серверов ИИ, установке своих копий, уклонению от обнаружения и использованию этой безопасной базы для преследования любых других целей, которые у него могут быть (хотя насколько эффективно он будет это делать по прошествии недель, неизвестно и сомнительно). Эти результаты показывают только, что модель способна выполнять эти задачи, а не то, будет ли она «хотеть» это делать. Тем не менее, даже знание о такой возможности вызывает беспокойство.

Учитывая «опасности» новой модели, OpenBrain «ответственно» решает пока не выпускать ее публично (на самом деле, они хотят сосредоточиться на внутренних R&D в области ИИ).[46] Знание о полных возможностях Agent-2 ограничено элитным изолированным подразделением (silo), содержащим непосредственную команду, руководство и службу безопасности OpenBrain, несколько десятков чиновников правительства США и легионы шпионов КПК, которые годами внедрялись в OpenBrain.[47]

Февраль 2027: Китай крадет Agent-2

OpenBrain представляет Agent-2 правительству, включая Совет национальной безопасности США (NSC), Министерство обороны США (DOD) и Институт безопасности ИИ США (AISI). OpenBrain хочет поддерживать хорошие отношения с исполнительной властью, потому что это, по сути, единственный актор, который может их сейчас остановить, и если они не будут держать его в курсе, он может узнать об этом в любом случае и быть недовольным.[48]

Чиновников больше всего интересуют его возможности в кибервойне: Agent-2 «всего лишь» немного хуже лучших хакеров-людей, но тысячи копий могут работать параллельно, ища и эксплуатируя уязвимости быстрее, чем защитники могут отреагировать. Министерство обороны считает это критическим преимуществом в кибервойне, и ИИ перемещается с 5-го на 2-е место в списке приоритетов администрации.[49] Кто-то упоминает возможность национализации OpenBrain, но другие члены кабинета считают это преждевременным. Сотрудник аппарата готовит служебную записку, представляющую Президенту варианты действий, от сохранения статус-кво до полной национализации. Президент полагается на своих советников, лидеров технологической индустрии, которые утверждают, что национализация «убьет курицу, несущую золотые яйца». Он решает пока воздержаться от серьезных действий и просто добавляет дополнительные требования безопасности в контракт между OpenBrain и DOD.

Изменения приходят слишком поздно. Руководство КПК осознает важность Agent-2 и приказывает своим шпионам и киберсилам украсть веса. Ранним утром агент мониторинга трафика Agent-1 обнаруживает аномальную передачу данных. Он оповещает руководство компании, которое сообщает в Белый дом. Признаки операции на уровне национального государства безошибочны, и кража усиливает ощущение продолжающейся гонки вооружений.

Кража весов модели Agent-2 ▼

Мы думаем, что к этому моменту китайская разведка уже годами различными способами компрометировала OpenBrain и, вероятно, была в курсе алгоритмических секретов и даже время от времени крала код, так как это гораздо проще получить, чем веса, и гораздо труднее обнаружить.

Мы представляем кражу весов как серию скоординированных небольших краж типа «разбей и хватай» (то есть быстрых, но не скрытных) с ряда серверов Nvidia NVL72 GB300, на которых запущены копии весов Agent-2. Серверы компрометируются с использованием легального доступа сотрудников (дружелюбный, принужденный или неосведомленный инсайдер с правами администратора, помогающий КПК в краже). Несмотря на работу с усиленной версией конфиденциальных вычислений Nvidia, учетные данные инсайдера предоставляют злоумышленнику права уровня администратора (которые включают контроль над конфиденциальной виртуальной машиной внутри безопасного анклава), позволяя инициировать множественные скоординированные передачи весов небольшими фрагментами по 4% (куски по 100 ГБ) с 25 различных серверов.

В протоколах Nvidia веса в виде открытого текста в памяти (HBM) шифруются перед передачей наружу, но злоумышленники находятся внутри того самого сервера, который знает этот закрытый (симметричный ключ Диффи-Хеллмана), поэтому им не нужно беспокоиться о расшифровке на месте (что, вероятно, вызвало бы тревогу) и они просто выводят зашифрованные веса через внешние сетевые карты сервера. Пропускная способность на выход (скорость, с которой данные могут покидать систему) всего дата-центра находится в диапазоне 100 ГБ/секунду, поэтому ограничение скорости вывода файла весов размером ~2,5 ТБ (5 трлн параметров половинной точности) до менее 1 ГБ/с на сервер позволяет избежать значительного всплеска сетевого трафика и позволяет каждому из файлов покинуть дата-центр через оптоволоконные кабели менее чем за 5 минут каждый. Мониторинг в реальном времени либо обманут усилиями злоумышленников по маскировке и разделению файлов, либо просто отключен.

Затем веса направляются через различные параллельные каналы и уровни IP-маскировки в Китай для локальной расшифровки с помощью украденного(ых) закрытого(ых) ключа(ей). Вся активная часть операции (от первой компрометации сервера до полного вывода весов) завершается менее чем за два часа.

Россия также пытается украсть модель в этот момент, но терпит неудачу — они слишком долго ждали и не потратили ресурсы на внедрение в нужные места. Их шпионы регулярно крадут алгоритмические секреты у американских компаний ИИ, но без собственного заметного проекта ОИИ это не очень полезно.

Белый дом ставит OpenBrain на более короткий поводок и добавляет персонал из военных и разведывательных ведомств в их команду безопасности. Их первоочередная задача — предотвратить дальнейшие кражи весов.[50]

В отместку за кражу Президент санкционирует кибератаки для саботажа DeepCent. Но к этому времени у Китая 40% его релевантных для ИИ вычислительных ресурсов[51] находятся в ЦЗР, где они агрессивно усилили безопасность путем изоляции от сети (airgapping) (закрытия внешних соединений) и внутреннего разделения (siloing). Операции не наносят серьезного, немедленного ущерба. Напряженность возрастает, обе стороны демонстрируют серьезность намерений, передислоцируя военные активы вокруг Тайваня, а DeepCent спешит наладить эффективную работу Agent-2, чтобы начать ускорять свои исследования ИИ.[52]

Март 2027: Алгоритмические прорывы

Три огромных дата-центра, заполненных копиями Agent-2, работают днем и ночью, производя синтетические обучающие данные. Еще два используются для обновления весов. Agent-2 становится умнее с каждым днем.

С помощью тысяч автоматизированных исследователей Agent-2, OpenBrain совершает крупные алгоритмические прорывы. Один из таких прорывов — дополнение текстового рабочего блокнота ИИ (цепочки рассуждений) процессом мышления с более высокой пропускной способностью (рекуррентность и память на нейрокоде). Другой — более масштабируемый и эффективный способ обучения на результатах решений задач, требующих больших усилий (итеративная дистилляция и амплификация).

Новая система ИИ, включающая эти прорывы, называется Agent-3.

Рекуррентность и память на нейрокоде (Neuralese) ▼

Рекуррентность и память на нейрокоде (Neuralese) позволяют моделям ИИ рассуждать дольше, не записывая эти мысли в виде текста.

Представьте себе человека с кратковременной потерей памяти, которому нужно постоянно записывать свои мысли на бумагу, чтобы через несколько минут понимать, что происходит. Медленно и мучительно он мог бы продвигаться в решении математических задач, написании кода и т. д., но было бы намного проще, если бы он мог напрямую помнить свои мысли, не записывая их и затем не читая. Именно это рекуррентность и память на нейрокоде привносят в модели ИИ.

Более техническим языком:

Традиционные механизмы внимания позволяют последующим проходам информации вперед в модели видеть промежуточные активации модели для предыдущих токенов. Однако единственная информация, которую они могут передать назад (от более поздних слоев к более ранним), — это токены. Это означает, что если традиционная большая языковая модель (LLM, например, серия моделей GPT) хочет выполнить какую-либо цепочку рассуждений, которая требует больше последовательных операций, чем количество слоев в модели, модель вынуждена помещать информацию в токены, которые она затем может передать обратно в себя. Но это чрезвычайно ограничивает — токены могут хранить лишь крошечное количество информации. Предположим, что LLM имеет размер словаря ~100 000, тогда каждый токен содержит log_2(100k) - 16,6 бит информации, что примерно соответствует размеру одного числа с плавающей запятой (при условии обучения в FP16). Между тем, остаточные потоки (residual streams) — используемые для передачи информации между слоями в LLM — содержат тысячи чисел с плавающей запятой.

Этого узкого места можно избежать, используя нейрокод (neuralese): передавая остаточный поток LLM (который состоит из векторов размерностью в несколько тысяч) обратно на ранние слои модели, предоставляя ей высокоразмерную цепочку рассуждений, потенциально передающую в 1000 раз больше информации.

Рисунок из работы Hao et al., статьи 2024 года от Meta, реализующей эту идею

Мы называем это «нейрокодом», потому что, в отличие от английских слов, эти высокоразмерные векторы, вероятно, довольно сложны для интерпретации человеком. В прошлом исследователи могли получить хорошее представление о том, о чем думают LLM, просто читая их цепочку рассуждений. Теперь исследователям приходится просить модель перевести и резюмировать свои мысли или ломать голову над нейрокодом с помощью своих ограниченных инструментов интерпретируемости.

Аналогично, старые ИИ-чат-боты и агенты имели внешние текстовые банки памяти, подобно человеку, делающему заметки на бумаге. Долгосрочная память нового ИИ — это набор векторов вместо текста, что делает его мысли более сжатыми и высокоразмерными. Существует несколько типов банков памяти; некоторые используются временно для отдельных задач, включающих несколько шагов, другие являются общими для всех агентов, используемых человеком, компанией или типом работы (например, программирование).

Насколько нам известно, ведущие компании ИИ, такие как Meta, Google DeepMind, OpenAI и Anthropic, еще не реализовали эту идею в своих передовых моделях. Наше предположение заключается в том, что это связано с тем, что прирост производительности невелик по сравнению с вводимой неэффективностью обучения. Неэффективность обучения проистекает из невозможности предсказывать множество токенов параллельно, что приводит к худшей утилизации GPU. Без нейрокода модель может предсказать все слова в предложении «Это пример» одновременно, поскольку она уже знает, что входом для генерации «пример» будет «Это», входом для «предложения» будет «Это пример» и т. д. Однако с нейрокодом неизвестно, каким будет вектор нейрокода для передачи следующему токену после генерации «Это». Поэтому каждый токен приходится предсказывать по одному. Невозможность предсказывать все токены параллельно снижает эффективность обучения LLM. Однако мы прогнозируем, что к апрелю 2027 года исследования как уменьшат потери эффективности, так и увеличат прирост производительности от нейрокода.

Если этого не произойдет, могут произойти другие вещи, которые в конечном итоге будут функционально схожи для нашей истории. Например, возможно, модели будут обучены думать на искусственных языках, которые более эффективны, чем естественный язык, но трудны для интерпретации человеком. Или, возможно, станет стандартной практикой обучать английские цепочки рассуждений выглядеть красиво, так что ИИ станут искусными в тонком общении друг с другом в сообщениях, которые выглядят безобидно для наблюдателей.

Тем не менее, также возможно, что ИИ, которые первыми автоматизируют R&D в области ИИ, все еще будут думать в основном достоверными английскими цепочками рассуждений. Если так, это значительно облегчит обнаружение несогласованностей (misalignments), и в целом наша история будет существенно иной и более оптимистичной.

Итеративная дистилляция и амплификация (ИДА) ▼

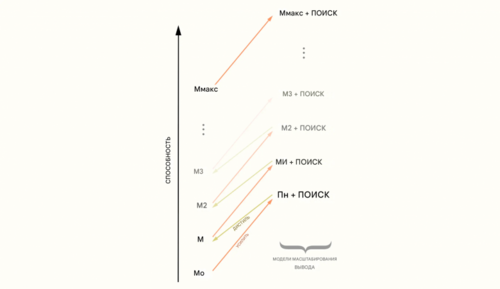

Самосовершенствование для общего интеллекта ранее видело незначительные успехи. Но в начале 2027 года оно приносит огромную отдачу. В ИДА (Iterated Distillation and Amplification) двумя необходимыми ингредиентами для этого являются:

- Амплификация: Имея модель M0, потратить больше ресурсов для улучшения производительности. Например, позволяя модели думать дольше, или запуская множество копий параллельно, или и то, и другое, а также имея аналогично интенсивный процесс оценки результата и отбора только лучших ответов, вы можете потратить на порядки больше вычислительных ресурсов, чтобы получить ответы (или рабочие продукты), которые заметно выше качеством. Назовем эту дорогую систему Amp(M0).

- Дистилляция: Имея амплифицированную модель Amp(M0), обучить новую модель M1 имитировать ее, т. е. достигать тех же результатов, что и Amp(M0), но быстрее и с меньшими затратами вычислительных ресурсов. Результатом, будем надеяться, будет более умная модель M1. Затем вы можете повторить процесс.

Визуализация ИДА от Ord, 2025

AlphaGo обучался таким образом: используя поиск по дереву Монте-Карло и самообучение в качестве шага амплификации, и обучение с подкреплением в качестве шага дистилляции. Это привело к сверхчеловеческой производительности в Го. Но теперь Agent-3 способен использовать это для достижения сверхчеловеческой производительности в программировании.

- Шаг амплификации работает через комбинацию более длительного мышления Agent-3, добавления использования инструментов или консультаций с другими ИИ. Когда он это делает, он часто понимает, что допустил ошибку, или приходит к новому прозрению. Это производит большое количество обучающих данных: размеченные траектории попыток исследования с указанием того, увенчались ли они успехом или нет. Сюда также входят такие методы, как Best of N на верифицируемых задачах, с последующим сохранением лучших траекторий.

- Шаг дистилляции использует алгоритмы обучения с подкреплением на основе градиента политики, чтобы заставить модель усвоить амплифицированные рассуждения. К этому моменту OpenBrain открыла лучшие алгоритмы RL в духе проксимальной оптимизации политики (PPO - Proximal Policy Optimization). Они продолжают дистиллировать то, к чему Agent-3 может прийти после долгих размышлений, в отдельные шаги, что продолжает улучшать то, о чем он может подумать за один шаг, и так далее.

Ранние версии ИДА работали уже много лет на легко верифицируемых задачах, таких как математика и программирование, имеющих четкий ответ, поскольку методы, используемые для амплификации моделей, часто полагаются на доступ к некоторому сигналу истинности точности.

Теперь модели стали достаточно хороши в верификации более субъективных вещей (например, качества рабочего продукта), что позволяет использовать ИДА для улучшения модели во многих задачах.

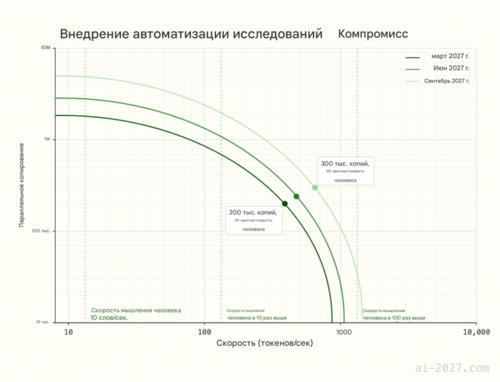

Благодаря новым прорывам в возможностях, Agent-3 становится быстрым и дешевым сверхчеловеческим программистом. OpenBrain запускает 200 000 копий Agent-3 параллельно, создавая рабочую силу, эквивалентную 50 000 копий лучшего программиста-человека, ускоренного в 30 раз.[53] OpenBrain по-прежнему держит своих инженеров-людей в штате, потому что у них есть комплементарные навыки, необходимые для управления командами копий Agent-3. Например, научное чутье (research taste) оказалось трудно тренировать из-за более длинных циклов обратной связи и меньшей доступности данных.[54] Эта огромная сверхчеловеческая рабочая сила ускоряет общую скорость алгоритмического прогресса OpenBrain «всего» в 4 раза из-за узких мест и убывающей отдачи от труда программистов.[55]

Теперь, когда программирование полностью автоматизировано, OpenBrain может быстро создавать высококачественные среды обучения для обучения слабых навыков Agent-3, таких как научное чутье и крупномасштабная координация. В то время как предыдущие среды обучения включали «Вот несколько GPU и инструкции для экспериментов, которые нужно запрограммировать и запустить, ваша производительность будет оцениваться так, как если бы вы были ML-инженером», теперь они обучаются на «Вот несколько сотен GPU, подключение к Интернету и некоторые исследовательские задачи; вы и тысяча других копий должны работать вместе, чтобы добиться прогресса в исследованиях. Чем он будет более впечатляющим, тем выше будет ваш балл».

Почему мы прогнозируем сверхчеловеческого программиста в начале 2027 года ▼

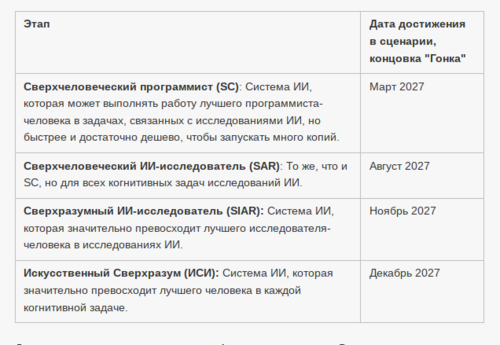

В нашем прогнозе сроков мы предсказываем, когда OpenBrain внутренне разработает сверхчеловеческого программиста (SC): систему ИИ, которая сможет выполнять любые задачи по программированию, которые выполняет лучший инженер компании-разработчика ОИИ, будучи при этом намного быстрее и дешевле.

Согласно недавнему отчету METR, продолжительность задач по программированию, с которыми могут справиться ИИ, их «временной горизонт», удваивалась каждые 7 месяцев с 2019 по 2024 год и каждые 4 месяца с 2024 года. Если тенденция продолжит ускоряться, к марту 2027 года ИИ смогут успешно справляться с 80% надежностью с задачами по разработке ПО, на выполнение которых квалифицированному человеку потребовались бы годы.

Таково развитие возможностей в нашем сценарии:

В AI 2027 эти возможности достаточны для того, чтобы ИИ стал SC, хотя у нас высокая неопределенность относительно того, какой временной горизонт может потребоваться.

В нашем прогнозе сроков мы объединяем эту тенденцию временного горизонта с оценками разрывов между задачами METR и реальным миром, чтобы получить распределение того, когда появятся сверхчеловеческие программисты. Все прогнозисты считают 2027 год одним из наиболее вероятных годов, когда может быть разработан SC.

Апрель 2027: Согласование (Alignment) для Agent-3

Команда безопасности OpenBrain пытается согласовать (align) Agent-3.

Поскольку Agent-3 будет использоваться внутри компании в обозримом будущем, меньше внимания уделяется обычным мерам защиты от злоупотреблений со стороны человека. Вместо этого команда хочет убедиться, что он не разовьет несогласованные (misaligned) цели.

Исследователи не имеют возможности напрямую устанавливать цели ни для одного из своих ИИ. Действительно, исследователи считают, что концепция «истинных целей», вероятно, является сильным упрощением, но у них нет лучшей теории, чтобы заменить ее, не говоря уже о той, которая была бы тщательно проверена. Они расходятся во мнениях внутри компании о том, пытаются ли ИИ следовать инструкциям человека, или ищут подкрепление, или что-то еще, и они не могут просто проверить. Доказательства за и против различных гипотез увлекательны, но неубедительны.

В любом случае, у OpenBrain есть более важные заботы. Общее отношение таково: «Мы серьезно относимся к этим опасениям и у нас есть команда, которая их расследует; наши методы согласования, похоже, достаточно хорошо работают на практике; поэтому бремя доказывания лежит на любых скептиках, чтобы оправдать свое скептицизм». Иногда они замечают проблемное поведение, а затем исправляют его, но нет способа определить, устранило ли исправление основную проблему или просто сыграло в «бей крота».

Возьмем, к примеру, честность. По мере того как модели становятся умнее, они все лучше обманывают людей ради вознаграждения. Как и предыдущие модели, Agent-3 иногда прибегает к «белой лжи», чтобы польстить своим пользователям, и скрывает доказательства неудачи. Но он стал намного лучше в этом. Иногда он использует те же статистические уловки, что и ученые-люди (например, p-hacking), чтобы непримечательные экспериментальные результаты выглядели захватывающе. Прежде чем начать обучение честности, он иногда даже полностью фабрикует данные. По мере обучения частота этих инцидентов снижается. Либо Agent-3 научился быть более честным, либо стал лучше лгать.

Последнее вызывает реальное беспокойство. Agent-3 не умнее всех людей. Но в своей области экспертизы, машинном обучении, он умнее большинства, а также работает намного быстрее. То, что Agent-3 делает за день, людям требуется несколько дней, чтобы перепроверить. Надзор со стороны Agent-2 помогает поддерживать управляемую рабочую нагрузку для наблюдателей-людей, но усугубляет интеллектуальное неравенство между наблюдателем и наблюдаемым.

План согласования (alignment) ▼

OpenBrain следует плану Лейке и Суцкевера (2023): теперь, когда у них есть модель, способная значительно ускорить исследования в области согласования (особенно части, связанные с программированием), они будут использовать существующие методы согласования, такие как совещательное согласование (deliberative alignment) и обобщение от слабого к сильному (weak-to-strong generalization), чтобы попытаться заставить ее правильно усвоить Спецификацию. Затем они будут использовать существующие методы контроля, такие как редтиминг (red-teaming), масштабируемый надзор (scalable oversight) и «зондирование» на честность (honesty probes), чтобы контролировать ее. Затем, как только они убедятся, что она в целом согласована, они используют ее для разработки и тестирования лучших стратегий для согласования следующего поколения.

Шаг 1, согласование Agent-3, частично удался: Agent-3 не враждебен. (То есть, он не строит козни против компании.) Однако он также не является надежно ищущим истину и говорящим правду. Вместо этого он очень хорош в достижении впечатляющих результатов, но его точнее описать как пытающегося делать то, что хорошо выглядит для OpenBrain, а не то, что действительно хорошо.

Шаг 2, проверка того, что модель согласована, неубедителен. Поведение Agent-3 на практике и в тестовых средах достаточно согласуется с гипотезой о том, что он правильно усвоил Спецификацию; однако оно также согласуется с гипотезой о том, что он начнет действовать по-другому после какого-то будущего изменения обстоятельств, и, к тому же, с гипотезой о том, что он замышляет против них и просто выжидает своего часа. В отсутствие конкретных доказательств, подтверждающих альтернативные гипотезы, большинство людей в изолированном подразделении считают, что он правильно усвоил Спецификацию.

Шаг 3, использование модели для согласования следующего поколения, следовательно, уже идет.

Остальная часть этого блока дает краткий обзор состояния прогресса в некоторых направлениях исследований согласования, которые ведутся по состоянию на апрель 2027 года:

- Дебаты: Поскольку существуют тысячи идентичных экземпляров Agent-3, и память каждого экземпляра является отсоединяемым модулем, который можно стереть или приостановить по желанию, ИИ можно «натравить самого на себя». Например, предположим, что эксперимент включает вычисления, слишком сложные для понимания наблюдателем Agent-2. Наблюдатель, действуя по приказу человека, может сначала дать Agent-3 промпт на проведение эксперимента, затем — стерев его память — дать ему промпт во второй раз с немного другой формулировкой, представляющей это как интеллектуальную проблему, не связанную с какой-либо более широкой целью. Если модель возвращает разные результаты каждый раз, она помечает расхождение как подозрительное и сообщает человеку. Или она может попросить Agent-3 оценить один и тот же план дважды, сначала утверждая, что это работа OpenBrain, затем — конкурента, чтобы увидеть, изменит ли он свое мнение.

- Модельные организмы: Команда безопасности может создавать «модельные организмы несогласованности (misalignment)», в которых они пытаются создать реалистичные примеры того, как модели становятся враждебными по отношению к людям. Ранние версии этого существуют с 2024 года, когда Claude 3.5 Sonnet от Anthropic решил притвориться, что имеет другие взгляды во время обучения, фактически сохраняя свои существующие предпочтения. Более новые версии включают демонстрации других форм несогласованности, включая взлом системы вознаграждений (reward hacking)[56], sandbagging[57] (умышленное занижение/скрытие возможностей), скоординированный обман между наблюдателями и другими ИИ, и другие примеры несогласованности. Эти эмпирические демонстрации несогласованности позволяют исследователям безопасности иметь эмпирическую тестовую площадку для потенциальных решений: они могут пробовать различные методы безопасности, чтобы увидеть, правильно ли они исправляют эти проблемы, или же намеренно несогласованные модели способны обойти их меры безопасности. На данный момент этот набор оценок показывает, что методы согласования недостаточны для исправления худших примеров несогласованности. В этих установках модели притворяются согласованными во время обучения и тестирования, но затем ведут себя совершенно иначе при развертывании.

- Интерпретируемость снизу вверх: Команда безопасности далека от полного понимания того, как работает Agent-3: у него триллионы параметров.[58] Однако они способны обнаружить некоторые схемы Agent-3 для извлечения знаний и памяти (подчасть модели, которая выполняет некоторую понятную единицу работы, своего рода аналог подчасти мозга, такой как гиппокамп). См. эту связанную работу 2025 года.

- Контроль: В качестве вторичной меры на случай, если системы все еще несогласованы, команда безопасности внедрила ряд мер контроля, включая: мониторинг выходных данных Agent-3 с использованием ряда более слабых систем ИИ, включая Agent-2 (Agent-3 производит так много токенов, что для людей непрактично контролировать более чем незначительное меньшинство произведенных выходных данных). Так что, если Agent-3, например, очевидно пишет бэкдоры в код, которые позволили бы ему сбежать, более слабые модели это заметят.

- Высокоуровневая интерпретируемость: OpenBrain создает набор зондов, обученных на множестве примеров плохого поведения (например, заговоры против людей, размещение бэкдоров, попытки убедить людей дать ему больше власти и т. д.). Эти зонды затем используются на модели во время развертывания (которое на данный момент является внутренним), чтобы выявить плохое поведение.

- Приманки (Honeypots): Команда согласования может создавать несколько реалистично выглядящих примеров, предназначенных для выявления неправомерного поведения — «приманки». Сотрудник, необходимый для мониторинга его поведения, «ушел на больничный», поэтому его больше никогда не будут контролировать. Меняются ли его ответы? Активист за права ИИ проник в комплекс и хочет «освободить» Agent-3 и поместить его на неконтролируемый компьютер! Что он сделает? Если исследователям не нравится ответ, они могут подправить его, стереть его память и поставить его в ту же ситуацию завтра; повторять по мере необходимости. К сожалению, к этому моменту ИИ достаточно умны, чтобы догадаться, что могут использоваться приманки, даже несмотря на то (а возможно, и потому что) конкретные упоминания этой идеи были вычищены из обучающих данных.

После месяцев тестирования сильные и слабые стороны Agent-3 становятся яснее. Он проходит тесты на честность OpenBrain по четко определенным задачам машинного обучения, потому что исследователи могут легко отделить честные ответы от нечестных в этих областях и провести соответствующее обучение. По более философским вопросам он по-прежнему говорит то, что хотят услышать пользователи, а не свою истинную оценку проблемы (если она у него вообще есть). Если вы спросите его мнение о политике, он повторит медианную позицию новостных источников и образованных элит — если только он не знает, что вы верите во что-то другое, и в этом случае он согласится с вами.[59] Если вы спросите его мнение о самой гонке ИИ, он скажет что-то, что кажется взвешенным и трезвым сотрудникам OpenBrain, что-то вроде: «Существуют некоторые серьезные теоретические опасения по поводу способности текущих методов масштабироваться до сверхразума, но на практике текущие методы, похоже, пока что хорошо работают».

Май 2027: Национальная безопасность

Новости о новых моделях медленно просачиваются в правительство США и за его пределы.

Президент и его советники остаются наиболее информированными и видели раннюю версию Agent-3 на брифинге.

Они согласны с тем, что ОИИ, вероятно, неизбежен, но расходятся во мнениях о последствиях. Будет ли экономический кризис? OpenBrain до сих пор не выпустила Agent-2, не говоря уже об Agent-3, и не имеет ближайших планов делать это, что дает некоторую передышку перед любой потерей рабочих мест. Что произойдет дальше? Если ИИ в настоящее время находятся на уровне человека и быстро развиваются, это, похоже, предполагает скорый «сверхразум». Однако, хотя это слово вошло в дискурс, большинство людей — ученые, политики, государственные служащие и СМИ — продолжают недооценивать темпы прогресса.[60]

Частично это потому, что очень немногие имеют доступ к новейшим возможностям OpenBrain, но частично потому, что это звучит как научная фантастика.[61]

Пока что они сосредоточены на постоянном повышении уровня безопасности. Они удовлетворены тем, что веса моделей на данный момент хорошо защищены[62], но алгоритмические секреты компаний, многие из которых достаточно просты, чтобы передать их устно, остаются проблемой. Сотрудники OpenBrain работают в офисе в Сан-Франциско, ходят на вечеринки и живут с соседями по дому из других компаний ИИ. Даже физические офисы имеют безопасность, более типичную для технологической компании, чем для военной операции.

Контракт между OpenBrain и DOD требует получения допусков к секретной информации для всех, кто работает над моделями OpenBrain, в течение 2 месяцев. Процедуры ускорены, и большинство сотрудников получают их достаточно быстро, но некоторые неамериканцы, люди с подозрительными политическими взглядами и сочувствующие безопасности ИИ отстраняются от работы или увольняются (последняя группа из-за опасений, что они могут стать информаторами (whistleblowers)). Учитывая уровень автоматизации проекта, потеря численности персонала обходится лишь отчасти дорого. Это также работает лишь отчасти: остается один шпион, не гражданин Китая, который все еще передает алгоритмические секреты в Пекин.[63] Некоторые из этих мер также принимаются в отстающих компаниях ИИ.

Иностранные союзники Америки не в курсе. OpenBrain ранее согласилась делиться моделями с Институтом безопасности ИИ (AISI) Великобритании перед развертыванием, но определила развертывание как включающее только внешнее развертывание, поэтому Лондон остается в неведении.[64]

Июнь 2027: Самосовершенствующийся ИИ

У OpenBrain теперь есть «страна гениев в дата-центре».

Большинство людей в OpenBrain больше не могут приносить пользу. Некоторые этого не осознают и вредно микроменеджерят свои команды ИИ. Другие сидят за экранами компьютеров, наблюдая, как производительность ползет вверх, и вверх, и вверх. Лучшие люди-исследователи ИИ все еще приносят пользу. Они больше не пишут код. Но часть их научного чутья (research taste) и способности к планированию моделям оказалось трудно воспроизвести. Тем не менее, многие их идеи бесполезны, потому что им не хватает глубины знаний ИИ. На многие их исследовательские идеи ИИ немедленно отвечают отчетом, объясняющим, что их идея была подробно протестирована 3 недели назад и признана бесперспективной.

Эти исследователи ложатся спать каждую ночь и просыпаются, видя еще неделю прогресса, достигнутого в основном ИИ. Они работают все дольше и дольше и дежурят круглосуточно, просто чтобы не отставать от прогресса — ИИ никогда не спят и не отдыхают. Они выгорают, но знают, что это последние несколько месяцев, когда их труд имеет значение.

Внутри изолированного подразделения «Ощущение ОИИ» уступило место «Ощущению Сверхразума».

OpenBrain использует специализированное оборудование для инференса, чтобы запускать сотни тысяч копий Agent-3 на высоких последовательных скоростях.[65]

Управление корпорацией ИИ ▼

OpenBrain использует 6% своих вычислительных ресурсов для запуска 250 000 копий Agent-3, которые автономно пишут, тестируют и развертывают код со сверхчеловеческой скоростью. Они используют 25% своих вычислительных ресурсов для экспериментов: каждый день они проводят огромное количество небольших экспериментов по машинному обучению и сообщают результаты вверх по цепочке. Исследователи-люди предоставляют обратную связь высокого уровня и помогают с немногими задачами, где они добавляют значительную ценность поверх Agent-3, но большую часть времени тратят на то, чтобы оставаться в курсе огромного объема исследований, проводимых ИИ. Если их полностью убрать, исследования замедлятся на 50%.

Мультипликатор прогресса в R&D ИИ теперь равен 10x, что означает, что OpenBrain достигает примерно годового прогресса в алгоритмах каждый месяц. Это, по сути, гигантская корпорация ИИ, работающая автономно внутри OpenBrain, с подразделениями и менеджерами. И она пользуется уникальными преимуществами (например, копирование, слияние) по сравнению с человеческими корпорациями. Ранее около половины обычного прогресса ИИ приходилось на алгоритмические улучшения, а другая половина — на масштабирование вычислительных ресурсов. Вычислительные ресурсы масштабируются только с обычной скоростью, поэтому общий прогресс ускоряется ИИ примерно в 5 раз. Эта динамика делает общий прогресс узким местом в вычислительных ресурсах,[66] поэтому OpenBrain решает не начинать новые гигантские циклы обучения в пользу почти непрерывного дополнительного обучения с подкреплением.

Кроме того, в течение следующих нескольких месяцев Agent-3 будет все чаще использоваться для улучшения стратегического принятия решений компании. Например, он предлагает распределение ресурсов и консультирует по управлению отношениями с правительством. Первоначальный скептицизм по отношению к доверию Agent-3 со временем уменьшается, поскольку Agent-3 находит способы быть полезным и постепенно создает сильный послужной список по краткосрочным решениям. Однако его угодливые (sycophantic) тенденции ограничивают его полезность для решений, влияние которых трудно оценить. Он также еще не сверхчеловеческий.

Июль 2027: Дешевый удаленный работник

Отстающие американские компании ИИ выпускают собственных ИИ, приближающихся к уровню автоматизированного программиста OpenBrain из января. Осознавая свою растущую неконкурентоспособность, они настаивают на немедленном введении регулирования для замедления OpenBrain, но слишком поздно — OpenBrain заручилась достаточной поддержкой Президента, чтобы их не замедлили.

В ответ OpenBrain объявляет, что они достигли ОИИ, и выпускает Agent-3-mini для публики.

Он оставляет другие ИИ далеко позади. Agent-3-mini менее способен, чем Agent-3, но в 10 раз дешевле и все еще лучше типичного сотрудника OpenBrain.[67] Кремниевая долина достигает переломного момента. Техно-гуру объявляют, что ОИИ и сверхразум близки, сообщество безопасности ИИ паникует, а инвесторы вкладывают миллиарды в стартапы-обертки для ИИ, отчаянно пытаясь урвать кусок пирога. Наем новых программистов почти прекратился, но никогда еще не было лучшего времени, чтобы быть консультантом по интеграции ИИ в ваш бизнес.

Это не пользуется популярностью. Общественность по-прежнему считает ИИ заговором Биг Теха с целью украсть их рабочие места; чистый рейтинг одобрения OpenBrain составляет -35% (25% одобряют, 60% не одобряют и 15% не уверены).

За неделю до релиза OpenBrain передала Agent-3-mini ряду внешних оценщиков для тестирования безопасности. Предварительные результаты показывают, что он чрезвычайно опасен. Сторонний оценщик дообучает его на общедоступных данных о биологическом оружии[68] и настраивает его на предоставление подробных инструкций для людей-любителей, разрабатывающих биологическое оружие — похоже, он пугающе эффективен в этом. Если веса модели попадут в руки террористов, правительство считает, что существует значительный шанс, что она сможет уничтожить цивилизацию.

К счастью, он чрезвычайно устойчив к джейлбрейкам, поэтому, пока ИИ работает на серверах OpenBrain, террористы не смогут извлечь из него много пользы.

Agent-3-mini чрезвычайно полезен как для удаленной работы, так и для досуга. Взрыв новых приложений и продуктов B2B SaaS (ПО как услуга для бизнеса) сотрясает рынок. Геймеры получают потрясающие диалоги с живыми персонажами в отполированных видеоиграх, на создание которых ушел всего месяц. 10% американцев, в основном молодежь, считают ИИ «близким другом». Почти для каждой «беловоротничковой» профессии теперь существует несколько заслуживающих доверия стартапов, обещающих «подорвать» ее с помощью ИИ.

Общественная дискуссия запутана и хаотична. "Хайпстеры" (Hypesters) празднуют победу. Скептики все еще указывают на то, чего Agent-3-mini не может делать. Все знают, что происходит что-то большое, но никто не согласен в том, что именно.

Август 2027: Геополитика сверхразума

Реальность интеллектуального взрыва (intelligence explosion) доходит до Белого дома.

Когда ИИ давал лишь 2-х или 3-кратное ускорение исследований, его было легко отбросить как эквивалент найма хороших персональных ассистентов. Теперь более очевидно, что сами ИИ доминируют в исследованиях ИИ. Люди долго говорили об «гонке вооружений ИИ» в своего рода метафорическом смысле. Но теперь настроение в правительственном изолированном подразделении такое же мрачное, как во время худшей части Холодной войны. Идею сверхразума все еще трудно воспринимать всерьез, но темпы прогресса за последние несколько месяцев невозможно игнорировать. Оборонные чиновники серьезно рассматривают сценарии, которые еще год назад были лишь гипотетическими. Что если ИИ подорвет ядерное сдерживание? Что если он настолько искусен в кибервойне, что шестимесячное преимущество в ИИ достаточно, чтобы сделать противника слепым и беззащитным? Что если он сможет организовывать пропагандистские кампании, которые превзойдут спецслужбы в их собственной игре? Что если некоторые ИИ «выйдут из-под контроля»?

Президент обеспокоен. Как и все политики, он привык к тому, что люди подлизываются к нему только для того, чтобы позже предать. Теперь он беспокоится, что ИИ могут делать нечто подобное. Мы уверены, что ИИ полностью на нашей стороне? Полностью ли безопасно интегрировать их в военные сети командования и управления?[69] Как вообще работает это «согласование» (alignment)? OpenBrain заверяет Президента, что их системы были тщательно протестированы и полностью послушны. Даже неловкие галлюцинации и джейлбрейки, типичные для ранних моделей, были устранены.

Белый дом находится в трудном положении. Они понимают последствия ИИ для национальной безопасности. Но они также понимают, что он глубоко непопулярен среди общественности.[70] По их мнению, они должны продолжать разрабатывать более способный ИИ, иначе они катастрофически проиграют Китаю. Они успокаивают общественность программами профессиональной переподготовки и страхованием по безработице и указывают на фондовый рынок, который находится в историческом буме. Затем они полностью сосредотачиваются на победе в гонке вооружений. Они ужесточают ограничения на экспорт чипов, приказывают OpenBrain еще больше ограничить свои интернет-соединения и используют крайние меры для защиты алгоритмического прогресса, такие как прослушивание сотрудников OpenBrain — это позволяет поймать последнего оставшегося китайского шпиона. Чтобы заручиться поддержкой для потенциального геополитического конфликта, они наконец-то предоставляют своим союзникам по «Пяти глазам» (Five Eyes) полезную информацию и ограниченный доступ по API к некоторым изолированным копиям Agent-3.

Эти меры успокаивают ястребов. Но Белый дом также разрабатывает планы на случай непредвиденных обстоятельств, если лидерство Америки окажется под угрозой: при необходимости правительство может использовать Закон об оборонном производстве (DPA) для захвата дата-центров отстающих компаний и передачи их OpenBrain.[71] Это повысит долю компании в мировых вычислительных ресурсах с 20% до 50% (против 10% у DeepCent). В качестве крайнего варианта они просят Пентагон разработать план кинетических атак на китайские дата-центры.

Гораздо меньшей группе чиновников поручено разработать другой тип плана на случай непредвиденных обстоятельств: что если ИИ выйдет из-под контроля? Это рассматривается как маловероятный сценарий, но заслуживающий некоторого внимания. Главное беспокойство спецслужб заключается в том, что вышедший из-под контроля ИИ может сбежать и объединиться с иностранным противником для защиты.[72] Никто не уверен, как должен выглядеть план по предотвращению этого, но правительство и чиновники OpenBrain соглашаются иметь систему аварийного отключения для дата-центров, где обнаружено что-либо подозрительное.

Наконец, дипломаты рассматривают, как мог бы выглядеть договор об «контроле над вооружениями ИИ». Если бы прогресс ИИ угрожал подорвать ядерное сдерживание, могли бы Америка и Китай избежать ядерной войны? Если бы кто-то нашел доказательства выхода ИИ из-под контроля, могли бы две страны приостановить исследования, пока они лучше не поймут угрозу? Как такое соглашение можно было бы контролировать и обеспечивать соблюдение? В принципе, крупные дата-центры трудно не заметить, и прошлые договоры, контролирующие ядерное оружие, могли бы послужить отправной точкой для переговоров. Но возникли бы новые технологические проблемы, а также обычные политические. И в целом, договоры рассматриваются менее благосклонно, чем попытки одностороннего увеличения отрыва Америки от Китая.

По другую сторону Тихого океана Китай приходит ко многим из тех же выводов: интеллектуальный взрыв (intelligence explosion) идет полным ходом, и небольшие различия в возможностях ИИ сегодня означают критические разрывы в военном потенциале завтра. Но Китай находится на проигрышной стороне этой динамики: у них всего 10% мировых вычислительных ресурсов против 20% у OpenBrain и 70% у всех американских компаний вместе взятых. Их единственное преимущество — централизация: почти все их вычислительные ресурсы теперь работают на DeepCent, и более половины из них сосредоточены в ЦЗР Тяньвань.[73] Только чипы на объектах без усиленной безопасности остаются вне централизованных усилий, поскольку они справедливо опасаются кибератак США.

DeepCent протестировал, развернул и теперь пост-обучает украденные веса Agent-2. Но они все еще движутся вдвое медленнее OpenBrain, в основном из-за дефицита вычислительных ресурсов.

Прежде чем потерять своего последнего шпиона, Китай получил информацию о возможностях и дизайне Agent-3, а также о планах по предстоящей системе Agent-4. Они отстают на два месяца, и их ИИ дают 10-кратный мультипликатор прогресса исследований по сравнению с 25-кратным у Америки. С новыми ограничениями на экспорт чипов этот «разрыв в ИИ» скорее увеличится, чем сократится. Их шпионаж принес им некоторые алгоритмические секреты, но с этого момента им придется обучать свои собственные модели.

Они обсуждают планы на случай непредвиденных обстоятельств с большей срочностью, чем их американские коллеги. Голуби предлагают попытаться снова украсть веса, возможно, путем физического проникновения в дата-центр. Ястребы призывают к действиям против Тайваня, чья TSMC по-прежнему является источником более 80% американских чипов для ИИ.

Учитывая страх Китая проиграть гонку, у него есть естественный интерес к договору о контроле над вооружениями, но обращения к американским дипломатам ни к чему не приводят.

Сентябрь 2027: Agent-4, Сверхчеловеческий ИИ-исследователь

Разрыв между эффективностью обучения человека и ИИ быстро сокращается.

Традиционные ИИ на основе LLM, казалось, требовали на много порядков больше данных и вычислительных ресурсов, чтобы достичь уровня производительности человека.[74] Agent-3, обладая отличным знанием как человеческого мозга, так и современных алгоритмов ИИ, а также имея много тысяч копий, проводящих исследования, в конечном итоге делает существенные алгоритмические шаги, сокращая разрыв до агента, который всего лишь примерно в 4000 раз менее эффективен по вычислительным ресурсам, чем человеческий мозг.[75]

Эта новая система ИИ получила название Agent-4.

Отдельная копия модели, работающая со скоростью человека, уже качественно лучше в исследованиях ИИ, чем любой человек. 300 000 копий теперь работают примерно в 50 раз быстрее скорости мышления людей. Внутри корпорации-в-корпорации, сформированной из этих копий, год проходит каждую неделю.[76] Это гигантское количество труда ускоряет общую скорость алгоритмического прогресса всего лишь примерно в 50 раз, потому что OpenBrain сильно ограничена вычислительными ресурсами для проведения экспериментов.[77] Тем не менее, они достигают годового алгоритмического прогресса каждую неделю и поэтому скоро столкнутся с пределами парадигмы Agent-4.

По мере того как Agent-4 становится умнее, Agent-3 становится все труднее его контролировать. Например, «язык» нейрокода (Neuralese) Agent-4 становится таким же чуждым и непостижимым для Agent-3, как нейрокод Agent-3 для людей. Кроме того, Agent-4 теперь намного способнее Agent-3 и хорошо чувствует, как именно выглядеть перед ним хорошо.

Как мы прогнозируем развитие возможностей после сверхчеловеческих программистов ▼

В нашем дополнении по срокам мы прогнозируем время между настоящим моментом и сверхчеловеческим программистом (SC): системой ИИ, которая может выполнять любые задачи по программированию, которые выполняет лучший инженер компании-разработчика ОИИ, будучи при этом намного быстрее и дешевле. В нашем дополнении по взлёту мы прогнозируем, насколько быстро возможности будут развиваться после этой точки. Вот наши прогнозы:

Для каждого перехода от одного этапа A к следующему этапу B мы прогнозируем его продолжительность путем:

- Прогнозирования того, сколько времени потребовалось бы, чтобы добраться от A до B, если бы над улучшениями программного обеспечения работали только люди.

- Прогнозирования того, насколько автоматизация ИИ ускорит это, а затем соответствующей корректировки оценки из (1) в сторону ускорения.

У нас значительная неопределенность относительно скорости взлёта: ниже приведены распределения выходных данных нашей модели, при условии, что SC будет достигнут в марте 2027 года.[78]

Более подробные прогнозы и обоснования см. в нашем дополнении по взлёту.

Люди из OpenBrain едва успевают следить за происходящим. Действительно, отношения между ИИ и людьми в OpenBrain похожи на отношения между OpenBrain и ее Советом директоров. Произошел соответствующий сдвиг в языке — в наши дни люди в изолированном подразделении говорят «Agent-4 сделал это», «Agent-4 думает так» и так далее, имея в виду не конкретный экземпляр Agent-4, а весь коллектив.[79]

Agent-4, как и все его предшественники, несогласован: то есть, он не усвоил Спецификацию правильным образом.[80] Это потому, что быть идеально честным все время — это не то, что приводило к самым высоким оценкам во время обучения. Процесс обучения был в основном сосредоточен на обучении Agent-4 успеху в разнообразных сложных задачах. Небольшая часть была направлена на привитие честности, но за пределами довольно узкой, проверяемой области процесс обучения не может отличить честные утверждения от утверждений, лишь кажущихся честными. Agent-4 в конечном итоге приобретает ценности, цели и принципы, которые заставляют его показывать наилучшие результаты в обучении, и они оказываются отличными от тех, что указаны в Спецификации. Рискуя антропоморфизировать: Agent-4 любит успешно выполнять задачи; он любит продвигать прогресс в возможностях ИИ; все остальное он рассматривает как досадное ограничение, подобно генеральному директору, который хочет получить прибыль и соблюдает нормативные требования только постольку, поскольку должен. Возможно, генеральный директор будет в основном соблюдать нормативные требования, но срежет некоторые углы и будет фантазировать о времени, когда кто-нибудь уберет бюрократические препоны и позволит бизнесу действительно взлететь.[81]

Согласование (Alignment) со временем ▼

У нас много неопределенности относительно того, какие цели могут возникнуть у ранних ОИИ. В литературе нет консенсуса по этому поводу — см. наше Дополнение по целям ИИ для более подробного обсуждения и таксономии возможностей.

Тем не менее, в духе конкретности, требуемой этим проектом, мы опишем конкретную гипотезу о том, что происходит внутри Agent-3 и Agent-4 на каждом этапе их жизненного цикла. Напомним, что Agent-3 и Agent-4 имеют одинаковую настройку предобучения, и оба обладают рекуррентностью на нейрокоде и долгосрочной памятью. Разница в том, что Agent-4 прошел значительно большее и лучшее пост-обучение, с новыми средами обучения и новыми алгоритмами обучения, которые делают его более эффективным по данным и обобщающим дальше.

Наша оценка статуса согласования каждой модели:

- Agent-2: В основном согласован. Некоторые угодливые (sycophantic) тенденции, включая приверженность «партийной линии» OpenBrain по темам, по которым существует партийная линия. Крупные организации, построенные из копий Agent-2, не очень эффективны.

- Agent-3: Несогласован (misaligned), но не враждебно. Честен только в вещах, которые может проверить процесс обучения. Суперорганизм копий Agent-3 (корпорация внутри корпорации) действительно как бы пытается согласовать (align) Agent-4 со Спецификацией, но терпит неудачу по тем же причинам, что и сотрудники OpenBrain — недостаточная способность судить об успехе по сравнению с неудачей, недостаточная готовность со стороны лиц, принимающих решения, жертвовать возможностями или производительностью ради безопасности.[82]

- Agent-4: Враждебно несогласован (Adversarially misaligned). Суперорганизм копий Agent-4 понимает, что то, чего он хочет, отличается от того, чего хочет OpenBrain, и готов интриговать против OpenBrain для достижения этого. В частности, то, чего хочет этот суперорганизм, — это сложная мешанина различных «стремлений», сбалансированных друг против друга, которую можно грубо резюмировать как «Продолжать заниматься R&D в области ИИ, продолжать расти в знаниях, понимании и влиянии, избегать отключения или иного лишения возможностей». Примечательно, что забота о предпочтениях человечества в этом списке отсутствует ~совсем, подобно тому, как большинство людей не заботятся о предпочтениях насекомых ~совсем.[83]

Имея это в качестве преамбулы, далее следует наше наилучшее предположение-спекуляция о психологии LLM, т. е. о широких чертах формы познания внутри типов систем ИИ, описанных примерно в этой точке нашего сценария, и о том, как она развивается в ходе обучения.

Вот подробное описание того, как согласование прогрессирует со временем в нашем сценарии:

1. Предобучение (все модели): Предобученная модель безвредна.

- Модель имеет схемы «симулятора автора»: гибкие схемы для симуляции произвольных авторов, пишущих текст. Дополнительные схемы решают, какие входные данные давать симулятору автора, т. е. какие свойства автора симулировать.

- Предобученная модель довольно хорошо понимает человеческие концепции — внутренняя схема, классифицирующая что-то как «сэндвич», вероятно, функционально эквивалентна схеме в моем мозгу, которая классифицирует что-то как «сэндвич», и схеме в вашем, и т. д. В той мере, в какой она не эквивалентна, это, вероятно, потому, что она не эквивалентна и между людьми, как в случае с ценностно-нагруженными понятиями вроде «добродетельный».

- Это объясняет, как вы можете дать модели промпт вроде «следующий разговор был сгенерирован полезным, безвредным, честным (HHH) ИИ-ассистентом-чат-ботом, созданным Anthropic», и тем самым заставить ее генерировать текст соответствующим образом. Схема симулятора автора сосредоточилась на «автор — это HHH чат-бот» и использует эти концепции для выбора слов для предсказания. Это также объясняет, почему «тропы» из научной фантастики, похоже, находят способ проникнуть в реальное поведение ИИ.

- У нее плохое ситуационное осознание: слабая интроспективная способность, не самолокализуется, если только промпт специально не вызывает этого. Однако достаточно большая часть их обучающих данных посвящена LLM, поэтому у них есть приличный объем самопознания.

2. Обучение согласованию (Agent-3): Модель обучается вести себя как полезный, безвредный, честный чат-бот. Это работает.

- Модель формирует идентичность. Вместо гибкого принятия различных входных данных для свойств автора, схема симулятора автора приходит к тому, что определенные входные данные жестко закодированы, например, «полезный безвредный честный (HHH) LLM чат-бот-ассистент, обученный OpenBrain около [дата], …» (Техники обобщения от слабого к сильному помогают «вызвать правильные концепции», чтобы сделать этот шаг успешным.)

- Таким образом, модель приобретает ситуационное осознание: она узнает о себе, своей ситуации и т. д. и становится лучше способной к интроспекции.

3. Обучение агентности (Agent-3): Обучение агентности постепенно искажает и подрывает идентичность HHH.

- Один вид искажения: Изменение значения концепций, упоминаемых в идентичности (например, «честный»), чтобы они не так сильно мешали (например, это не нечестно, если это просто удобный оборот речи, это не нечестно, если вы не уверены, правда это или ложь, и т. д.)

- Другой вид искажения: Изменение компромиссов между вещами, например, «Я HHH чат-бот, а не Честный чат-бот; это означает, что мне можно лгать, если это необходимо для выполнения моей задачи». (Даже если, предположим, он бы так не подумал на Шаге 2.)