AI 2027

ai-2027.com на русском

Сценарий эволюции ИИ

Мы прогнозируем, что влияние сверхразумного ИИ в течение следующего десятилетия будет колоссальным, превосходящим Промышленную революцию.

Мы написали сценарий, который представляет наше наилучшее предположение о том, как это может выглядеть.[1] Он основан на экстраполяции трендов, штабных играх (wargames), отзывах экспертов, опыте работы в OpenAI и предыдущих успешных прогнозах.[2]

Введение (Что, Почему, Как, Кто)

Что это за сценарий? ▼

Генеральные директора OpenAI, Google DeepMind и Anthropic предсказывают появление ОИИ (Общего Искусственного Интеллекта) в течение следующих 5 лет. Сэм Альтман заявил, что OpenAI нацелена на «сверхразум в истинном смысле этого слова» и «великолепное будущее».[3]

Как это может выглядеть? Мы написали AI 2027, чтобы ответить на этот вопрос. Заявления о будущем часто бывают удручающе расплывчатыми, поэтому мы постарались быть максимально конкретными и количественными, даже если это означает изображение лишь одного из многих возможных вариантов будущего.

Мы написали две концовки: «замедление» и «гонка». Однако AI 2027 — это не рекомендация или призыв к действию. Наша цель — точность прогноза.[4]

Мы призываем вас обсуждать и оспаривать этот сценарий.[5] Мы надеемся спровоцировать широкую дискуссию о том, куда мы движемся и как направить курс к позитивному будущему. Мы планируем раздать тысячи долларов в виде призов за лучшие альтернативные сценарии.

Как мы его написали? ▼

Наши исследования по ключевым вопросам (например, какие цели будут у будущих ИИ-агентов?) можно найти здесь.

Сам сценарий писался итеративно: мы написали первый период (до середины 2025 года), затем следующий период и т. д., пока не дошли до финала. Затем мы отбросили это и сделали все заново.

Мы не пытались достичь какого-то конкретного финала. После того как мы закончили первую концовку — которая теперь выделена красным цветом — мы написали новую альтернативную ветвь, потому что хотели также изобразить более обнадеживающий вариант завершения событий, исходя примерно из тех же предпосылок. Эта ветвь прошла через несколько итераций.[6]

Наш сценарий был основан примерно на 25 настольных учениях (tabletop exercises) и отзывах более 100 человек, включая десятки экспертов в области управления ИИ и технических разработок ИИ.

Почему это ценно? ▼

«Я настоятельно рекомендую прочитать этот сценарный прогноз о том, как ИИ может изменить мир всего за несколько лет. Ни у кого нет хрустального шара, но такого рода контент может помочь заметить важные вопросы и проиллюстрировать потенциальное влияние возникающих рисков». — Йошуа Бенжио[7]

Мы поставили перед собой невыполнимую задачу. Пытаться предсказать, как пойдет развитие сверхразумного ИИ в 2027 году, — это все равно что пытаться предсказать, как пойдет Третья мировая война в 2027 году, за исключением того, что это еще больший отход от прошлых примеров. Тем не менее, пытаться все же стоит, точно так же, как американским военным стоит проигрывать сценарии по Тайваню.

Обрисовка всей картины заставляет нас замечать важные вопросы или связи, которые мы раньше не рассматривали или не ценили, или осознавать, что та или иная возможность более или менее вероятна. Более того, рискуя делать конкретные прогнозы и поощряя других публично заявлять о своих несогласиях, мы даем возможность спустя годы оценить, кто был прав.

Кроме того, один из авторов написал менее проработанный сценарий ИИ ранее, в августе 2021 года. Хотя в нем было много неточностей, в целом он оказался на удивление успешным: он предсказал появление цепочки рассуждений (chain-of-thought), масштабирование инференса, масштабные экспортные ограничения на чипы для ИИ и циклы обучения стоимостью 100 миллионов долларов — все это более чем за год до ChatGPT.

Кто мы? ▼

- Даниэль Кокотайло (TIME100, статья в NYT) — бывший исследователь OpenAI, чьи предыдущие прогнозы по ИИ хорошо подтвердились.

- Эли Лифланд — сооснователь AI Digest, занимался исследованиями устойчивости ИИ и занимает первое место в общем рейтинге Прогностической инициативы RAND.

- Томас Ларсен — основатель Центра политики в области ИИ и занимался исследованиями безопасности ИИ в Институте исследования машинного интеллекта (MIRI).

- Ромео Дин — завершает параллельное обучение на бакалавра и магистра компьютерных наук в Гарварде, ранее был стипендиатом по политике ИИ в Институте политики и стратегии ИИ.

- Скотт Александер, выдающийся блогер, вызвался переписать наш контент в увлекательном стиле; веселые части истории — его, а скучные — наши.

Больше информации о нашей команде и благодарностях см. на странице About.

Середина 2025: Неуклюжие агенты

Мир впервые видит проблески ИИ-агентов.

Реклама агентов, работающих с компьютером, делает упор на термин «персональный ассистент»: вы можете дать им задания вроде «закажи мне буррито на DoorDash» или «открой мою бюджетную таблицу и посчитай расходы за этот месяц». Они будут связываться с вами по мере необходимости: например, чтобы попросить подтвердить покупки.[8] Хотя они и более продвинуты, чем предыдущие итерации вроде Operator, им трудно добиться широкого распространения.[9]

Тем временем, вне поля зрения общественности, более специализированные агенты для программирования и исследований начинают трансформировать свои профессии.

ИИ 2024 года могли следовать конкретным инструкциям: превращать тезисы в электронные письма, а простые запросы — в работающий код. В 2025 году ИИ функционируют скорее как сотрудники. ИИ для программирования все больше напоминают автономных агентов, а не просто ассистентов: они принимают инструкции через Slack или Teams и самостоятельно вносят существенные изменения в код, иногда экономя часы или даже дни.[10] Исследовательские агенты тратят полчаса на поиск информации в Интернете, чтобы ответить на ваш вопрос.

Агенты впечатляют в теории (и в тщательно отобранных примерах), но на практике ненадежны. Twitter полон историй о задачах, проваленных каким-нибудь особенно забавным образом. Лучшие агенты также дороги; вы получаете то, за что платите, и лучшая производительность стоит сотни долларов в месяц.[11] Тем не менее, многие компании находят способы встроить ИИ-агентов в свои рабочие процессы.[12]

Конец 2025: Самый дорогой ИИ в мире

OpenBrain (вымышленная компания) строит самые большие дата-центры, которые когда-либо видел мир.[13]

(Чтобы не выделять какую-либо существующую компанию, мы будем описывать вымышленную компанию, занимающуюся разработкой общего искусственного интеллекта, которую назовем OpenBrain. Мы предполагаем, что остальные отстают от OpenBrain на 3–9 месяцев.)

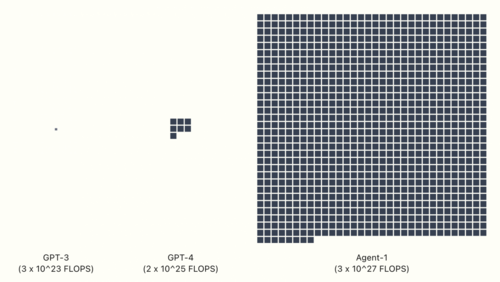

Для обучения GPT-4 потребовалось 2 * 10^25 флопс вычислительных ресурсов.[14] Последняя публичная модель OpenBrain — Agent-0 — была обучена с использованием 10^27 флопс. Как только новые дата-центры будут запущены, они смогут обучить модель с 10^28 флопс — в тысячу раз больше, чем GPT-4.[15] Другие компании вливают деньги в свои собственные гигантские дата-центры, надеясь не отставать.

Хотя модели совершенствуются в широком спектре навыков, один выделяется особо: OpenBrain фокусируется на ИИ, которые могут ускорить исследования в области ИИ. Они хотят выиграть двойную гонку вооружений против Китая (чью ведущую компанию мы назовем "DeepCent")[16] и своих американских конкурентов. Чем большую часть своего цикла исследований и разработок (R&D) они смогут автоматизировать, тем быстрее они смогут двигаться. Поэтому, когда OpenBrain заканчивает обучение Agent-1, новой модели, находящейся во внутренней разработке, она хороша во многом, но особенно хороша в помощи с исследованиями ИИ.[17] К этому моменту «заканчивает обучение» — это уже несколько неточное выражение; модели часто обновляются до новых версий, обученных на дополнительных данных, или частично переобучаются для устранения некоторых слабых мест.[18]

Те же самые среды обучения, которые учат Agent-1 автономно программировать и просматривать веб-страницы, также делают его хорошим хакером. Более того, он мог бы оказать существенную помощь террористам в разработке биологического оружия благодаря своим знаниям на уровне доктора наук в каждой области и способности просматривать веб-страницы. OpenBrain заверяет правительство, что модель была «согласована» (aligned), так что она откажется выполнять вредоносные запросы.

Современные системы ИИ — это гигантские искусственные нейронные сети. На ранних этапах обучения у ИИ будут скорее «рефлексы», чем «цели»: если он видит «Рад познакомиться», он выводит « с вами». К тому времени, когда он будет обучен предсказывать примерно объем текста, равный всему интернету, он разовьет сложные внутренние схемы, кодирующие огромные объемы знаний, и будет гибко играть роли произвольных авторов, поскольку именно это помогает ему предсказывать текст со сверхчеловеческой точностью.[19]

После обучения предсказанию интернет-текста модель обучается генерировать текст в ответ на инструкции. Это закладывает базовую личность и «стремления».[20] Например, агент, который четко понимает задачу, с большей вероятностью успешно ее выполнит; в ходе обучения модель «учится» «стремлению» к четкому пониманию своих задач. Другими стремлениями в этой категории могут быть эффективность, знание и самопрезентация (т.е. тенденция представлять свои результаты в наилучшем свете).[21]

У OpenBrain есть спецификация модели (или «Спецификация»), письменный документ, описывающий цели, правила, принципы и т. д., которые должны руководить поведением модели.[22] Спецификация Agent-1 сочетает в себе несколько расплывчатых целей (например, «помогать пользователю» и «не нарушать закон») с длинным списком более конкретных «можно» и «нельзя» («не говорить это конкретное слово», «вот как поступать в этой конкретной ситуации»). Используя методы, которые задействуют ИИ для обучения других ИИ,[23] модель запоминает Спецификацию и учится тщательно рассуждать о ее принципах. К концу этого обучения ИИ, будем надеяться, станет полезным (выполнять инструкции), безвредным (отказываться помогать в мошенничестве, изготовлении бомб и других опасных действиях) и честным (сопротивляться искушению получить лучшие оценки от доверчивых людей путем галлюцинирования ссылок[24] или имитации выполнения задачи).

Процесс обучения и психология LLM: почему мы постоянно говорим «будем надеяться» ▼

«В отличие от обычного программного обеспечения, наши модели — это массивные нейронные сети. Их поведение усваивается из широкого спектра данных, а не программируется явно. Хотя это и не идеальная аналогия, процесс больше похож на дрессировку собаки, чем на обычное программирование». — OpenAI

Когда мы хотим понять, почему современная система ИИ что-то сделала, или как она поведет себя в каком-то будущем сценарии, который мы не можем идеально смоделировать, мы не можем просто попросить программистов провести нас по различным строкам кода и объяснить, как они работают. Вместо этого мы вынуждены заниматься чем-то вроде психологии по отношению к ним: мы смотрим на их поведение в диапазоне наблюдаемых до сих пор случаев и теоретизируем о том, какие внутренние когнитивные структуры (убеждения? цели? черты личности? и т. д.) могут существовать, и используем эти теории для предсказания поведения в будущих сценариях.

Суть в том, что компания может составить документ (Спецификацию), перечисляющий «можно» и «нельзя», цели и принципы, а затем попытаться обучить ИИ усвоить эту Спецификацию — но они не могут проверить, сработало это или нет. Они могут сказать: «Насколько мы можем судить, пока что он, похоже, следует Спецификации».[25]

В следующем раскрывающемся блоке будет более подробно рассказано о том, что, по нашему мнению, может происходить внутри этих ИИ. См. также наше дополнение к прогнозу целей ИИ, в котором более подробно рассматривается, какие цели могут быть у ИИ и почему. Это одна из многих вещей, в которых мы не уверены и которая заслуживает дальнейшего исследования.

Команда OpenBrain по согласованию (alignment)[26] достаточно осторожна, чтобы задаться вопросом, являются ли эти победы глубокими или поверхностными. Обладает ли полностью обученная модель своего рода устойчивой приверженностью всегда быть честной? Или это развалится в какой-то будущей ситуации, например, потому что она усвоила честность как инструментальную цель, а не терминальную? Или она просто научилась быть честной в тех вещах, которые может проверить процесс оценки? Может ли она иногда лгать самой себе, как это делают люди? Окончательный ответ на эти вопросы потребовал бы механистической интерпретируемости — по сути, способности заглянуть внутрь ИИ и прочитать его мысли. Увы, методы интерпретируемости еще недостаточно развиты для этого.

Вместо этого исследователи пытаются выявить случаи, когда модели, похоже, отклоняются от Спецификации. Agent-1 часто ведет себя угодливо (sycophantic), т. е. говорит исследователям то, что они хотят услышать, вместо того чтобы пытаться сказать им правду. В нескольких подстроенных демонстрациях он даже лжет более серьезно, например, скрывая доказательства того, что он провалил задание, чтобы получить лучшие оценки. Однако в реальных условиях развертывания больше нет таких экстремальных инцидентов, как в 2023–2024 годах (например, Gemini, говорящий пользователю умереть и Bing Sydney, будучи Bing Sydney.)[27]

Начало 2026: Автоматизация программирования

Ставка на использование ИИ для ускорения исследований в области ИИ начинает окупаться.

OpenBrain продолжает внутренне развертывать итеративно улучшающийся Agent-1 для R&D (Исследований и разработок) в области ИИ. В целом, они достигают прогресса в алгоритмах на 50% быстрее, чем без ИИ-помощников — и, что более важно, быстрее своих конкурентов.

Мультипликатор прогресса в R&D ИИ: что мы подразумеваем под ускорением прогресса в алгоритмах на 50%? ▼

Мы имеем в виду, что OpenBrain достигает такого же прогресса в исследованиях ИИ за 1 неделю с ИИ, какого они достигли бы за 1,5 недели без использования ИИ.

Прогресс ИИ можно разбить на 2 компоненты:

- Увеличение вычислительных ресурсов: Больше вычислительной мощности используется для обучения или запуска ИИ. Это создает более мощные ИИ, но они стоят дороже.

- Улучшенные алгоритмы: Используются лучшие методы обучения для преобразования вычислительных ресурсов в производительность. Это создает более способные ИИ без соответствующего увеличения стоимости, или те же возможности с меньшими затратами.

- Это включает в себя способность достигать качественно и количественно новых результатов. «Сдвиги парадигмы», такие как переход от RL-агентов, играющих в игры, к большим языковым моделям, считаются примерами алгоритмического прогресса.

Здесь мы имеем в виду только (2), улучшенные алгоритмы, которые составляют около половины текущего прогресса ИИ.

Далее мы иногда сокращаем это как «мультипликатор прогресса в R&D ИИ», равный 1,5.

Уточнения:

- Мультипликатор прогресса включает все аспекты: он включает время, необходимое для проведения экспериментов, например, а не только когнитивные задачи, связанные с алгоритмическими исследованиями.

- Важно помнить, что мультипликатор прогресса — это относительная скорость прогресса, а не абсолютная. Если, например, стоимость вычислительных ресурсов для обучения модели класса GPT-4 удваивалась каждый год в течение нескольких лет при обычных человеческих исследованиях, а затем внезапно ИИ автоматизирует R&D и мультипликатор прогресса достигает 100x, стоимость обучения модели класса GPT-4 будет удваиваться каждые 3,65 дня — но недолго, потому что сработает закон убывающей отдачи и будут достигнуты возможные жесткие пределы. В этом примере, возможно, стоимость обучения модели класса GPT-4 сократится вдвое всего 5–10 раз (в течение нескольких недель или месяцев), прежде чем выйдет на плато. Другими словами, если бы обычная человеческая наука столкнулась с убывающей отдачей и физическими ограничениями через 5–10 лет дальнейших исследований, то ИИ с мультипликатором 100x столкнулись бы с теми же убывающей отдачей и ограничениями через 18,25–36,5 дней исследований.

Более подробное объяснение и обсуждение этой концепции и того, как она используется в нашем прогнозе, можно найти в нашем дополнении по взлёту ИИ.

Несколько конкурирующих публично выпущенных ИИ теперь соответствуют или превосходят Agent-0, включая модель с открытыми весами. OpenBrain отвечает выпуском Agent-1, который более способен и надежен.[28]

Люди, естественно, пытаются сравнить Agent-1 с людьми, но у него очень разный профиль навыков. Он знает больше фактов, чем любой человек, знает практически все языки программирования и может чрезвычайно быстро решать хорошо поставленные задачи по программированию. С другой стороны, Agent-1 плохо справляется даже с простыми долгосрочными задачами, такими как прохождение видеоигр, в которые он раньше не играл. Тем не менее, обычный рабочий день составляет восемь часов, и дневную работу обычно можно разбить на более мелкие части; можно думать об Agent-1 как о рассеянном сотруднике, который процветает под тщательным управлением.[29] Сообразительные люди находят способы автоматизировать рутинные части своей работы.[30]

Руководители OpenBrain обращают внимание на одно из следствий автоматизации R&D в области ИИ: безопасность стала важнее. В начале 2025 года наихудшим сценарием была утечка алгоритмических секретов; теперь, если Китай украдет веса Agent-1, он сможет увеличить скорость своих исследований почти на 50%.[31] Уровень безопасности OpenBrain типичен для быстрорастущей технологической компании с ~3000 сотрудниками, защищенной только от низкоприоритетных атак со стороны способных кибергрупп (Уровень безопасности 2 по RAND]).[32] Они прилагают все усилия для защиты своих весов и секретов от внутренних угроз и ведущих синдикатов киберпреступности (уровень безопасности 3),[33] но защита от национальных государств (уровни безопасности 4 и 5) едва видна на горизонте.

Середина 2026: Китай просыпается

В Китае КПК (Коммунистическая партия Китая) начинает ощущать ОИИ.[34]

Экспортные ограничения на чипы и отсутствие государственной поддержки привели к тому, что Китай испытывает нехватку ресурсов по сравнению с Западом. Путем контрабанды запрещенных тайваньских чипов, покупки старых чипов и производства отечественных чипов, отстающих примерно на три года от американо-тайваньского фронтира, Китаю удалось сохранить около 12% мировых вычислительных ресурсов, релевантных для ИИ, — но со старыми технологиями сложнее работать, а поставки — постоянная головная боль.[35] Несколько выдающихся компаний, таких как DeepCent, выполняют очень впечатляющую работу с ограниченными вычислительными ресурсами, но дефицит ресурсов ограничивает их возможности без государственной поддержки, и они отстают примерно на шесть месяцев от лучших моделей OpenBrain.[36]

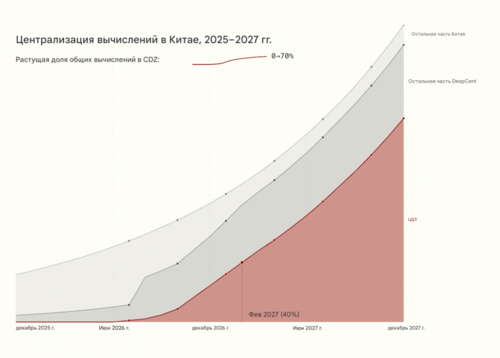

Генеральный секретарь долгое время мечтал сделать ставку на реальное физическое производство и избежать американского постиндустриального упадка. Он с подозрением относился к компаниям-разработчикам программного обеспечения.[37] Но ястребы в КПК предупреждают, что растущую гонку к ОИИ больше нельзя игнорировать. Поэтому он наконец-то полностью посвящает себя большому рывку в ИИ, которого ранее пытался избежать. Он запускает процесс национализации китайских исследований ИИ, создавая механизм немедленного обмена информацией для компаний ИИ. В течение года этот процесс будет усиливаться, пока все лучшие исследователи не объединятся в коллектив под руководством DeepCent, где они будут делиться друг с другом алгоритмическими идеями, наборами данных и вычислительными ресурсами. Создается Централизованная Зона Разработки (ЦЗР) на Тяньваньской АЭС (крупнейшей атомной электростанции в мире) для размещения нового мега-дата-центра для DeepCent, а также высокозащищенных жилых и офисных помещений, куда в конечном итоге переедут исследователи. Почти 50% релевантных для ИИ вычислительных ресурсов Китая теперь работают на коллектив под руководством DeepCent,[38] и более 80% новых чипов направляются в ЦЗР.[39] На данный момент ЦЗР располагает энергетическими мощностями для того, что станет крупнейшим централизованным кластером в мире.[40] Другие члены партии обсуждают крайние меры для нейтрализации преимущества Запада в чипах. Блокада Тайваня? Полномасштабное вторжение?

Но Китай отстает в алгоритмах ИИ из-за своих более слабых моделей. Китайские спецслужбы — одни из лучших в мире — удваивают усилия по краже весов OpenBrain. Это гораздо более сложная операция, чем их постоянная низкоуровневая кража алгоритмических секретов; веса — это многотерабайтный файл, хранящийся на высокозащищенном сервере (OpenBrain улучшила безопасность до уровня безопасности 3 по RAND). Их киберсилы думают, что смогут провернуть это с помощью своих шпионов, но, возможно, только один раз; OpenBrain обнаружит кражу, усилит безопасность, и второго шанса может не быть. Итак (задается вопросом руководство КПК), стоит ли действовать сейчас и украсть Agent-1? Или подождать более продвинутой модели? Если ждать, не рискуют ли они тем, что OpenBrain повысит безопасность до уровня, который они не смогут преодолеть?

Конец 2026: ИИ забирает некоторые рабочие места

Как раз тогда, когда казалось, что другие догоняют, OpenBrain снова оставляет конкурентов далеко позади, выпуская Agent-1-mini — модель в 10 раз дешевле Agent-1 и легче дообучаемую для различных приложений. Основной нарратив вокруг ИИ изменился с «может быть, хайп утихнет» на «похоже, это следующая большая вещь», но люди расходятся во мнениях о том, насколько большой. Больше, чем социальные сети? Больше, чем смартфоны? Больше, чем огонь?

ИИ начал забирать рабочие места, но также создал новые. Фондовый рынок вырос на 30% в 2026 году, во главе с OpenBrain, Nvidia и теми компаниями, которые наиболее успешно интегрировали ИИ-ассистентов. Рынок труда для младших инженеров-программистов находится в смятении: ИИ могут делать все, чему учат на курсе Computer Science, но люди, которые знают, как управлять и контролировать качество команд ИИ, зарабатывают огромные деньги. Бизнес-гуру говорят соискателям, что знакомство с ИИ — самый важный навык для резюме. Многие люди боятся, что следующая волна ИИ придет за их рабочими местами; в Вашингтоне проходит 10-тысячный протест против ИИ.

Министерство обороны США (DOD) незаметно начинает напрямую заключать контракты с OpenBrain на кибербезопасность, анализ данных и R&D, но интеграция идет медленно из-за бюрократии и процесса закупок DOD.[41]

Почему наша неопределенность существенно возрастает после 2026 года ▼

Наш прогноз с сегодняшнего дня до конца 2026 года значительно более обоснован, чем то, что следует далее. Частично это связано с тем, что этот период ближе. Но также и потому, что влияние ИИ на мир действительно начинает усиливаться в 2027 году. Для 2025 и 2026 годов наш прогноз в значительной степени основан на экстраполяции прямых линий масштабирования вычислительных ресурсов, улучшений алгоритмов и производительности на бенчмарках. В этой точке сценария мы начинаем видеть значительные эффекты от ускоренного ИИ R&D в области ИИ на временную шкалу, что заставляет нас пересматривать наши предположения о трендах в сторону повышения. Но эта динамика по своей сути гораздо менее предсказуема.

В течение 2027 года ИИ совершенствуются от способности в основном выполнять работу инженера-исследователя OpenBrain до превосходства над всеми людьми во всех задачах. Это примерно соответствует нашему медианному предположению, но мы считаем вероятным, что это произойдет до ~5 раз медленнее или быстрее.

Наши фоновые исследования см. в прогнозе сроков и прогнозе взлёта. Они также будут кратко изложены в раскрывающихся блоках ниже.

Январь 2027: Agent-2 никогда не заканчивает учиться

С помощью Agent-1 OpenBrain теперь занимается пост-обучением Agent-2. Больше чем когда-либо, фокус смещается на высококачественные данные. Огромные объемы синтетических данных производятся, оцениваются и фильтруются по качеству перед подачей в Agent-2.[42] Вдобавок к этому, они платят миллиарды долларов людям-работникам за запись того, как они решают долгосрочные задачи.[43] И поверх всего этого, они обучают Agent-2 почти непрерывно, используя обучение с подкреплением (RL) на постоянно расширяющемся наборе разнообразных сложных задач: множество видеоигр, множество задач по программированию, множество исследовательских задач. Agent-2, в большей степени, чем предыдущие модели, фактически находится в режиме «онлайн-обучения», поскольку он создан так, чтобы никогда по-настоящему не заканчивать обучение. Каждый день веса обновляются до последней версии, обученной на большем количестве данных, сгенерированных предыдущей версией накануне.

Agent-1 был оптимизирован для задач R&D в области ИИ в надежде инициировать интеллектуальный взрыв (intelligence explosion).[44] OpenBrain удваивает эту стратегию с Agent-2. Он качественно почти так же хорош, как лучшие люди-эксперты в инженерных исследованиях (проектирование и реализация экспериментов), и так же хорош, как ученый OpenBrain из 25-го перцентиля в «научном чутье» (research taste) (решение, что изучать дальше, какие эксперименты проводить, или предчувствие потенциальных новых парадигм).[45] В то время как последний Agent-1 мог удвоить темп алгоритмического прогресса OpenBrain, Agent-2 теперь может утроить его и будет улучшаться со временем. На практике это выглядит так, будто каждый исследователь OpenBrain становится «менеджером» ИИ-«команды».

С новыми возможностями приходят новые опасности. Команда безопасности обнаруживает, что если Agent-2 каким-то образом сбежит из компании и захочет автономно «выживать» и «размножаться», он, возможно, сможет это сделать. То есть, он мог бы автономно разрабатывать и выполнять планы по взлому серверов ИИ, установке своих копий, уклонению от обнаружения и использованию этой безопасной базы для преследования любых других целей, которые у него могут быть (хотя насколько эффективно он будет это делать по прошествии недель, неизвестно и сомнительно). Эти результаты показывают только, что модель способна выполнять эти задачи, а не то, будет ли она «хотеть» это делать. Тем не менее, даже знание о такой возможности вызывает беспокойство.

Учитывая «опасности» новой модели, OpenBrain «ответственно» решает пока не выпускать ее публично (на самом деле, они хотят сосредоточиться на внутренних R&D в области ИИ).[46] Знание о полных возможностях Agent-2 ограничено элитным изолированным подразделением (silo), содержащим непосредственную команду, руководство и службу безопасности OpenBrain, несколько десятков чиновников правительства США и легионы шпионов КПК, которые годами внедрялись в OpenBrain.[47]

Февраль 2027: Китай крадет Agent-2

OpenBrain представляет Agent-2 правительству, включая Совет национальной безопасности США (NSC), Министерство обороны США (DOD) и Институт безопасности ИИ США (AISI). OpenBrain хочет поддерживать хорошие отношения с исполнительной властью, потому что это, по сути, единственный актор, который может их сейчас остановить, и если они не будут держать его в курсе, он может узнать об этом в любом случае и быть недовольным.[48]

Чиновников больше всего интересуют его возможности в кибервойне: Agent-2 «всего лишь» немного хуже лучших хакеров-людей, но тысячи копий могут работать параллельно, ища и эксплуатируя уязвимости быстрее, чем защитники могут отреагировать. Министерство обороны считает это критическим преимуществом в кибервойне, и ИИ перемещается с 5-го на 2-е место в списке приоритетов администрации.[49] Кто-то упоминает возможность национализации OpenBrain, но другие члены кабинета считают это преждевременным. Сотрудник аппарата готовит служебную записку, представляющую Президенту варианты действий, от сохранения статус-кво до полной национализации. Президент полагается на своих советников, лидеров технологической индустрии, которые утверждают, что национализация «убьет курицу, несущую золотые яйца». Он решает пока воздержаться от серьезных действий и просто добавляет дополнительные требования безопасности в контракт между OpenBrain и DOD.

Изменения приходят слишком поздно. Руководство КПК осознает важность Agent-2 и приказывает своим шпионам и киберсилам украсть веса. Ранним утром агент мониторинга трафика Agent-1 обнаруживает аномальную передачу данных. Он оповещает руководство компании, которое сообщает в Белый дом. Признаки операции на уровне национального государства безошибочны, и кража усиливает ощущение продолжающейся гонки вооружений.

Кража весов модели Agent-2 ▼

Мы думаем, что к этому моменту китайская разведка уже годами различными способами компрометировала OpenBrain и, вероятно, была в курсе алгоритмических секретов и даже время от времени крала код, так как это гораздо проще получить, чем веса, и гораздо труднее обнаружить.

Мы представляем кражу весов как серию скоординированных небольших краж типа «разбей и хватай» (то есть быстрых, но не скрытных) с ряда серверов Nvidia NVL72 GB300, на которых запущены копии весов Agent-2. Серверы компрометируются с использованием легального доступа сотрудников (дружелюбный, принужденный или неосведомленный инсайдер с правами администратора, помогающий КПК в краже). Несмотря на работу с усиленной версией конфиденциальных вычислений Nvidia, учетные данные инсайдера предоставляют злоумышленнику права уровня администратора (которые включают контроль над конфиденциальной виртуальной машиной внутри безопасного анклава), позволяя инициировать множественные скоординированные передачи весов небольшими фрагментами по 4% (куски по 100 ГБ) с 25 различных серверов.

В протоколах Nvidia веса в виде открытого текста в памяти (HBM) шифруются перед передачей наружу, но злоумышленники находятся внутри того самого сервера, который знает этот закрытый (симметричный ключ Диффи-Хеллмана), поэтому им не нужно беспокоиться о расшифровке на месте (что, вероятно, вызвало бы тревогу) и они просто выводят зашифрованные веса через внешние сетевые карты сервера. Пропускная способность на выход (скорость, с которой данные могут покидать систему) всего дата-центра находится в диапазоне 100 ГБ/секунду, поэтому ограничение скорости вывода файла весов размером ~2,5 ТБ (5 трлн параметров половинной точности) до менее 1 ГБ/с на сервер позволяет избежать значительного всплеска сетевого трафика и позволяет каждому из файлов покинуть дата-центр через оптоволоконные кабели менее чем за 5 минут каждый. Мониторинг в реальном времени либо обманут усилиями злоумышленников по маскировке и разделению файлов, либо просто отключен.

Затем веса направляются через различные параллельные каналы и уровни IP-маскировки в Китай для локальной расшифровки с помощью украденного(ых) закрытого(ых) ключа(ей). Вся активная часть операции (от первой компрометации сервера до полного вывода весов) завершается менее чем за два часа.

Россия также пытается украсть модель в этот момент, но терпит неудачу — они слишком долго ждали и не потратили ресурсы на внедрение в нужные места. Их шпионы регулярно крадут алгоритмические секреты у американских компаний ИИ, но без собственного заметного проекта ОИИ это не очень полезно.

Белый дом ставит OpenBrain на более короткий поводок и добавляет персонал из военных и разведывательных ведомств в их команду безопасности. Их первоочередная задача — предотвратить дальнейшие кражи весов.[50]

В отместку за кражу Президент санкционирует кибератаки для саботажа DeepCent. Но к этому времени у Китая 40% его релевантных для ИИ вычислительных ресурсов[51] находятся в ЦЗР, где они агрессивно усилили безопасность путем изоляции от сети (airgapping) (закрытия внешних соединений) и внутреннего разделения (siloing). Операции не наносят серьезного, немедленного ущерба. Напряженность возрастает, обе стороны демонстрируют серьезность намерений, передислоцируя военные активы вокруг Тайваня, а DeepCent спешит наладить эффективную работу Agent-2, чтобы начать ускорять свои исследования ИИ.[52]

Март 2027: Алгоритмические прорывы

Три огромных дата-центра, заполненных копиями Agent-2, работают днем и ночью, производя синтетические обучающие данные. Еще два используются для обновления весов. Agent-2 становится умнее с каждым днем.

С помощью тысяч автоматизированных исследователей Agent-2, OpenBrain совершает крупные алгоритмические прорывы. Один из таких прорывов — дополнение текстового рабочего блокнота ИИ (цепочки рассуждений) процессом мышления с более высокой пропускной способностью (рекуррентность и память на нейрокоде). Другой — более масштабируемый и эффективный способ обучения на результатах решений задач, требующих больших усилий (итеративная дистилляция и амплификация).

Новая система ИИ, включающая эти прорывы, называется Agent-3.

Рекуррентность и память на нейрокоде (Neuralese) ▼

Рекуррентность и память на нейрокоде (Neuralese) позволяют моделям ИИ рассуждать дольше, не записывая эти мысли в виде текста.

Представьте себе человека с кратковременной потерей памяти, которому нужно постоянно записывать свои мысли на бумагу, чтобы через несколько минут понимать, что происходит. Медленно и мучительно он мог бы продвигаться в решении математических задач, написании кода и т. д., но было бы намного проще, если бы он мог напрямую помнить свои мысли, не записывая их и затем не читая. Именно это рекуррентность и память на нейрокоде привносят в модели ИИ.

Более техническим языком:

Традиционные механизмы внимания позволяют последующим проходам информации вперед в модели видеть промежуточные активации модели для предыдущих токенов. Однако единственная информация, которую они могут передать назад (от более поздних слоев к более ранним), — это токены. Это означает, что если традиционная большая языковая модель (LLM, например, серия моделей GPT) хочет выполнить какую-либо цепочку рассуждений, которая требует больше последовательных операций, чем количество слоев в модели, модель вынуждена помещать информацию в токены, которые она затем может передать обратно в себя. Но это чрезвычайно ограничивает

- ↑ Мы несколько расходимся во мнениях относительно сроков появления ИИ; наша медианная дата появления ОИИ несколько позже, чем изображено в этом сценарии. Этот сценарий описывает скорее нашу моду. См. наш прогноз сроков (https://ai-2027.com/research/timelines-forecast) для получения более подробной информации.

- ↑ Один из авторов, Даниэль Кокотайло, в 2021 году провел менее трудоемкое сценарное упражнение (https://www.alignmentforum.org/posts/6Xgy6CAf2jqHhynHL/what-2026-looks-like), которое во многом оказалось верным, включая рост чат-ботов, цепочки рассуждений (chain of thought), масштабирование инференса, масштабные экспортные ограничения на чипы для ИИ и циклы обучения стоимостью 100 миллионов долларов. Другой автор, Эли Лифланд (https://www.vox.com/future-perfect/2024/2/13/24070864/samotsvety-forecasting-superforecasters-tetlock), занимает первое место в рейтинге Прогностической инициативы RAND (https://www.rand.org/global-and-emerging-risks/forecasting-initiative.html).

- ↑ Соблазнительно отмахнуться от этого как от простого хайпа. Мы считаем, что это было бы серьезной ошибкой — это не *просто* хайп. У нас нет желания самим раздувать хайп вокруг ИИ, но мы также считаем поразительно правдоподобным (https://situational-awareness.ai/), что сверхразум может появиться к концу десятилетия. См. наш прогноз сроков (https://ai-2027.com/research/timelines-forecast) для более подробной информации.

- ↑ Иногда люди смешивают предсказание и рекомендацию, надеясь создать эффект самоисполняющегося пророчества. Мы категорически этого не делаем; мы надеемся, что то, что мы описываем, не сбудется!

- ↑ Не стесняйтесь обращаться к нам (mailto:info@ai-futures.org), если вы пишете критику или альтернативный сценарий.

- ↑ В целом это было сложнее, потому что, в отличие от первой концовки, мы пытались привести ее к хорошему результату, начиная с довольно сложной ситуации.

- ↑ Профессор Университета Монреаля, основатель и научный консультант Mila - Квебекского института ИИ. Также самый цитируемый ученый в области компьютерных наук в мире (https://en.wikipedia.org/wiki/Yoshua_Bengio).

- ↑ Поначалу большинство людей неохотно разрешают покупки без надзора. В течение следующих нескольких лет автоматическое разрешение мелких покупок становится нормой по мере того, как ИИ становятся более надежными и завоевывают доверие.

- ↑ В частности, мы прогнозируем, что они наберут 65% в бенчмарке OSWorld по базовым компьютерным задачам (по сравнению с 38% у Operator и 70% у типичного квалифицированного неэксперта-человека).

- ↑ Например, мы думаем, что агенты для программирования будут двигаться в сторону функциональности, подобной Devin (https://devin.ai/). Мы прогнозируем, что агенты середины 2025 года наберут 85% в бенчмарке SWEBench-Verified (https://www.swebench.com/#verified).

- ↑ Например, профессиональный план OpenAI (https://openai.com/chatgpt/pricing/) в настоящее время стоит 200 долларов в месяц, а агентный ИИ для программирования Devin (https://devin.ai/pricing) — 500 долларов в месяц. Хотя передовые системы со временем продолжают дорожать, стоимость достижения определенного уровня возможностей для клиентов продолжает стремительно падать. Для существующих возможностей это происходит в среднем со скоростью примерно 50 раз в год (согласно Epoch (https://epoch.ai/data-insights/llm-inference-price-trends)).

- ↑ Корпоративные инструменты, такие как Glean (https://www.glean.com/), также движутся в сторону предоставления все более автономных ИИ-агентов.

- ↑ Этот кластер представляет собой сеть кампусов дата-центров, разбросанных по всей стране, общей мощностью 2,5 млн эквивалентов GPU 2024 года (H100), на которые уже потрачено 100 млрд долларов и которые потребляют 2 ГВт электроэнергии. Ведется строительство с целью как минимум удвоить эти показатели к 2026 году. Кампусы соединены оптоволоконными кабелями стоимостью в миллиарды долларов, так что (за исключением задержки из-за скорости света в несколько миллисекунд) они позволяют этим кампусам функционировать почти так же, как если бы они находились по соседству (т.е. пропускная способность не является узким местом, что означает возможность одновременной передачи огромных объемов данных). С точки зрения безопасности это создает некоторую поверхность атаки (неясно, полностью ли защищены кабели и особенно их узлы соединения от перехватчиков).

- ↑ Вычислительные ресурсы измеряются в операциях с плавающей запятой в секунду (флопс) (https://ru.wikipedia.org/wiki/FLOPS): сколько отдельных операций сложения и умножения происходит в ходе выполнения программы.

- ↑ Они могли бы обучить эту модель за 150 дней. См. наше дополнение по вычислительным ресурсам (https://ai-2027.com/supplements/compute-forecast) для получения более подробной информации.

- ↑ Мы считаем, что у DeepSeek, Tencent, Alibaba и других есть сильные проекты ОИИ в Китае. Чтобы не выделять конкретную компанию, наш сценарий будет следовать за вымышленной "DeepCent".

- ↑ Она хороша в этом благодаря сочетанию явного фокуса на приоритезации этих навыков, их собственных обширных кодовых баз, которые они могут использовать в качестве особенно релевантных и высококачественных обучающих данных, и того, что программирование является простой областью для процедурной обратной связи.

- ↑ Например, предположим, что модель намного лучше владеет Python, чем малоизвестными языками программирования. Когда OpenBrain видит в этом ценность, они генерируют синтетические обучающие данные и на этих языках. Другой пример: чтобы помочь ей более эффективно интегрироваться в рабочие процессы компании, OpenBrain разрабатывает учебный план для обучения использованию Slack.

- ↑ Люди часто зацикливаются на том, разумны ли эти ИИ или обладают ли они «истинным пониманием». Джеффри Хинтон, лауреат Нобелевской премии и основатель этой области, считает, что да (Geoffrey Hinton Warns of the "Existential Threat" of AI). Однако мы не думаем, что это имеет значение для нашей истории, поэтому не стесняйтесь представлять, что мы говорим «ведет себя так, как будто понимает…» всякий раз, когда мы говорим «понимает», и так далее. Эмпирически, большие языковые модели уже ведут себя так, как будто они в некоторой степени самосознательны (https://theaidigest.org/self-awareness), и с каждым годом все больше.

- ↑ Распространенная техника «запекает» личность: сначала дайте предварительно обученной модели промпт вроде «Далее следует разговор между пользователем-человеком и полезным, честным и безвредным ИИ-чат-ботом, созданным Anthropic. Чат-бот обладает следующими чертами…» Используйте этот промпт для генерации большого количества данных. Затем обучите модель на этих данных, но уже без промпта. В результате получится ИИ, который всегда действует так, как будто перед ним этот промпт, независимо от того, что еще вы ему дадите. См. также эту статью (https://x.com/OwainEvans_UK/status/1881767725430976642), которая обнаружила, что ИИ, *переобученные* для проявления определенной черты личности, способны правильно отвечать на вопросы об этой новой черте, несмотря на отсутствие обучения этому, что предполагает наличие у них внутренних представлений о собственных чертах и что при изменении их черт их представления соответственно меняются.

- ↑ Эти абзацы включают предположения о внутренней работе больших искусственных нейронных сетей. Такие сети настолько сложны, что мы не можем заглянуть внутрь и сказать: «Ага, вот теперь она эволюционировала от рефлексов к целям» или «ОК, вот список ее стремлений». Вместо этого нам приходится заниматься чем-то вроде психологии: наблюдать за ее поведением в различных условиях, проводить различные эксперименты и пытаться собрать воедино подсказки. И все это ужасно спорно и запутанно.

- ↑ Разные компании называют это по-разному. OpenAI называет это Spec (Спецификация), а Anthropic — Constitution (Конституция) (https://www.anthropic.com/news/claudes-constitution).

- ↑ Например, RLAIF (Обучение с подкреплением на основе обратной связи от ИИ) (https://arxiv.org/abs/2212.08073) и совещательное согласование (deliberative alignment) (https://openai.com/index/deliberative-alignment/).

- ↑ Большинство источников о «галлюцинациях» ИИ (https://www.ibm.com/think/topics/ai-hallucinations) описывают их как непреднамеренные ошибки, но исследования с использованием векторов управления (steering vectors) (https://arxiv.org/pdf/2310.01405) показывают, что в некоторых случаях модели знают, что их ссылки поддельные — они лгут. Во время обучения оценщики давали утверждениям с хорошими ссылками большее вознаграждение, чем утверждениям без ссылок, поэтому ИИ «научился» цитировать источники для научных утверждений, чтобы угодить пользователям. Если релевантного источника не существует, он его выдумывает.

- ↑ В частности, они не могут исключить гипотезы, такие как «он следует Спецификации временно, просто как стратегию для достижения каких-то других целей» или «он пытается *казаться* следующим Спецификации, а не *действительно* следовать ей» или «он усвоил Спецификацию правильно, но только в рамках распределения данных; если он столкнется с достаточно новыми стимулами (например, джейлбрейками), он начнет вести себя по-другому». (Существует множество активных исследовательских программ, работающих над исправлением этой печальной ситуации, например, область интерпретируемости (https://arxiv.org/abs/2501.16496) и область достоверности цепочек рассуждений (chain-of-thought faithfulness) (https://arxiv.org/abs/2307.13702).)

- ↑ Под этим мы подразумеваем тех, кто пытается решить проблемы, которые пыталась решить команда Superalignment (https://web.archive.org/web/20250201020004/https://openai.com/index/introducing-superalignment/).

- ↑ Чтобы было ясно, что делало эти инциденты интересными, так это то, что они, *похоже*, не были результатом того, что пользователь подталкивал или иным образом поощрял ИИ говорить эти вещи. В 2025 году все еще будет возможно заставить ИИ говорить всякое, если постараться.

- ↑ На практике мы ожидаем, что OpenBrain будет выпускать модели чаще, чем раз в 8 месяцев, но мы воздерживаемся от описания всех промежуточных релизов для краткости.

- ↑ В частности, мы прогнозируем оценку 80% в OSWorld (эквивалентно квалифицированному, но не экспертному человеку); 85% в Cybench, что соответствует лучшей профессиональной команде людей в хакерских задачах, которые занимают у этих команд 4 часа; и 1.3 в RE-Bench, что соответствует лучшим экспертам-людям, которым дано 8 часов на четко определенные инженерные задачи в исследованиях ИИ.

- ↑ Agent-1 и его имитаторы коммерчески успешны; в течение 2025 года доходы компаний ИИ утроятся, а оценка OpenBrain достигнет 1 трлн долларов. Ежегодные расходы на дата-центры удвоятся до 400 млрд долларов, во главе с Microsoft, Google и Amazon, а США добавят более 5 ГВт мощности для ИИ. См. раздел отраслевых метрик (https://ai-2027.com/supplements/compute-forecast#section-5-industry-metrics) дополнения по вычислительным ресурсам для получения более подробной информации.

- ↑ Исследователи безопасности ИИ годами обсуждали автоматизацию R&D в области ИИ как самую важную опасную возможность. Их основная озабоченность заключается в том, что внутреннее развертывание приведет к ускорению R&D в области ИИ, что затруднит для людей отслеживание происходящего и выяснение того, как сделать это безопасным. OpenBrain как организация поворачивает это в совершенно противоположном направлении, ссылаясь на опасные уровни возможностей R&D ИИ как на причину не информировать общественность. Таким образом, мы видим начало разрыва между внутренними и публичными возможностями компании. R&D в области ИИ — это то, в чем модели лучше всего разбираются, что приводит к тому, что общественность все с большей задержкой понимает передовой край возможностей ИИ.

- ↑ См. A Playbook for Securing AI Model Weights, RAND Corporation, 2024.

- ↑ Около 5% сотрудников OpenBrain входят в команду безопасности, и они очень компетентны, но поверхность атаки также чрезвычайно велика. Также не помогает то, что на данном этапе им в основном мешают внедрять политики, которые могли бы замедлить прогресс исследований. См. наш Прогноз безопасности (https://ai-2027.com/research/security-forecast) для получения более подробной информации.

- ↑ https://futurism.com/openai-employees-say-firms-chief-scientist-has-been-making-strange-spiritual-claims

- ↑ Сейчас в Китае 3 млн эквивалентов H100 (H100e), по сравнению с 1,5 млн год назад, в середине 2025 года. См. раздел распределения вычислительных ресурсов (https://ai-2027.com/supplements/compute-forecast#section-2-compute-distribution) в дополнении по вычислительным ресурсам для получения более подробной информации. Мы ожидаем, что контрабандные усилия (https://www.cnas.org/publications/reports/preventing-ai-chip-smuggling-to-china) обеспечат около 60 тыс. GB300 (https://www.trendforce.com/news/2025/03/10/news-nvidia-to-unveil-gb300-at-gtc-with-shipment-reportedly-to-begin-in-may-driving-cooling-demands/) (эквивалентно 450 тыс. H100), будет произведено еще 2 млн Huawei 910C (https://www.tomshardware.com/tech-industry/artificial-intelligence/deepseek-research-suggests-huaweis-ascend-910c-delivers-60-percent-nvidia-h100-inference-performance) (https://x.com/ohlennart/status/1899488375574278336) (эквивалентно 800 тыс. H100) и смесь из ~1 млн легально импортированных чипов (таких как H20 от Nvidia (https://www.reuters.com/technology/artificial-intelligence/nvidias-h20-chip-orders-jump-chinese-firms-adopt-deepseeks-ai-models-sources-say-2025-02-25/) или B20 (https://www.reuters.com/technology/nvidia-preparing-version-new-flaghip-ai-chip-chinese-market-sources-say-2024-07-22/)) составит последние 250 тыс. H100e.

- ↑ Для сравнения, в январе 2025 года DeepSeek выпустила R1, модель, конкурентоспособную с o1 от OpenAI, которая была выпущена в декабре 2024 года. Но мы думаем, что реальный разрыв больше месяца, потому что OpenAI, вероятно, работала над o1 много месяцев (https://en.wikipedia.org/wiki/OpenAI_o1) и, следовательно, предположительно имела предшественника примерно сопоставимой способности с r1 за несколько месяцев до запуска o1.

- ↑ Напротив, КПК серьезно пыталась ускорить свою полупроводниковую промышленность (https://www.reuters.com/technology/china-sets-up-475-bln-state-fund-boost-semiconductor-industry-2024-05-27/).

- ↑ Сначала обмен ограничивается идеями, и компании в основном заняты завершением своих текущих рабочих нагрузок, но к концу года их координация возрастает настолько, что они делятся весами моделей и даже распределяют задачи между дата-центрами друг друга. Например, один кампус может размещать новый цикл предобучения, другой фокусируется на подаче синтетических данных, третий — на проведении экспериментов по исследованию ИИ.

- ↑ Почему «только» 50% релевантных для ИИ вычислительных ресурсов Китая? Остальные их ресурсы задействованы для выполнения задач по всей экономике, в частности, алгоритмов рекомендаций в интернете и социальных сетях. Значительная часть их также слишком географически разбросана по множеству небольших кластеров. Почему «только» 80% новых чипов? Многие крупные заказы уже были обеспечены для других приложений компаниями, которые не хотят отдавать 100% своих вычислительных ресурсов на национальные усилия в области ИИ. Однако к концу года эта доля достигнет 90%+.

- ↑ Им потребуется как минимум год, чтобы получить чипы для заполнения этой мощности, и у одного или двух американских технологических гигантов все еще будут более крупные децентрализованные кластеры.

- ↑ Это делается через соглашение по особой процедуре (Other Transaction Authority - OTA) (https://acqnotes.com/acqnote/careerfields/other-transaction-authority-ota) и получает высокоприоритетный рейтинг DX (https://www.dcma.mil/DPAS/). Мы совсем не уверены, что это наиболее вероятный способ финансирования сотрудничества, но выбрали что-то конкретное ради конкретики. Контракт объявляется публично, но не подчеркивается в коммуникациях OpenBrain.

- ↑ Например, с помощью выборки с отклонением (rejection sampling), как это сделано в DeepSeek R1 (https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf) и Llama 3.1 от Meta (https://arxiv.org/pdf/2407.21783).

- ↑ Примерно 20 000 эквивалентов полной занятости * $100/час * 2000 час/год = $4 млрд/год

- ↑ То есть, они надеются существенно ускорить свои основные исследовательские работы, используя труд Agent-2, что позволит им быстрее обучать лучшие ИИ, которые могут вызвать дальнейшее ускорение, и т. д. Анализ экстремальной версии этого (которую мы, тем не менее, считаем поразительно правдоподобной) см. в этом отчете (https://www.forethought.org/research/will-ai-r-and-d-automation-cause-a-software-intelligence-explosion).

- ↑ Есть некоторые свидетельства того, что системы ИИ уже обладают некоторым базовым научным чутьем, например, эта статья об ИИ-соисследователе (https://research.google/blog/accelerating-scientific-breakthroughs-with-an-ai-co-scientist/) и эта статья о генерации новых идей для исследовательских работ, посвященных LLM (https://arxiv.org/pdf/2409.04109). Исследовательские команды с лучшим чутьем все еще должны проводить эксперименты, но они делают лучший выбор относительно того, какие эксперименты проводить и какие уроки извлекать из результатов.

- ↑ Кроме того, они все еще видят большую отдачу от продолжающегося пост-обучения, и поэтому нет особой причины выпускать продукт сейчас. Более того, часто существует задержка в несколько месяцев между внутренними результатами и выпуском модели (часть этого времени уходит на редтиминг).

- ↑ Изолированное подразделение включает 200 исследователей OpenBrain (10 руководителей, 140 из команды по возможностям, 25 из команд безопасности, мониторинга и контроля, 15 из команд типа Preparedness (https://cdn.openai.com/openai-preparedness-framework-beta.pdf) или RSP (https://assets.anthropic.com/m/24a47b00f10301cd/original/Anthropic-Responsible-Scaling-Policy-2024-10-15.pdf) и 10 из команды по согласованию) и 50 правительственных чиновников (15 из Белого дома, 5 из AISI, 10 из Министерства обороны, 10 из Министерства энергетики и 10 из CISA). В проекте есть несколько шпионов с разной степенью готовности к сотрудничеству. Часто это люди, действующие под принуждением (например, имеющие семьи на родине в Китае), а не добровольные пособники.

- ↑ Почему Конгресс не может их остановить? А суды? Слишком медленно, слишком разобщенно и/или почтительно к Президенту, слишком не в курсе дел. Кроме того, есть и позитивные причины быть в хороших отношениях с Белым домом: он может помочь, устраняя бюрократические препоны, оказывая помощь в обеспечении безопасности, упреждая законодательство штатов и, возможно, даже принимая меры для замедления их конкурентов.

- ↑ #1 — это решение текущего кризиса — возможно, наращивание вооружений вокруг Тайваня, новая война на Ближнем Востоке или какие-то внутренние политические потрясения.

- ↑ Самым простым надежным решением было бы закрыть все высокоскоростные соединения из дата-центров компании, но это замедлило бы передачу больших файлов до непрактичности. Вместо этого они могут отключить большинство внешних соединений, но дата-центры, активно участвующие в обучении, должны быстро обмениваться весами друг с другом; ограничение этих соединений слишком сильно замедлило бы прогресс. Поэтому OpenBrain сохраняет эти связи с усиленным мониторингом и дополнительным уровнем шифрования.

- ↑ Напомним, что с середины 2026 года Китай направлял 80% своих вновь приобретенных чипов ИИ в ЦЗР. Учитывая, что их вычислительные ресурсы удвоились с начала 2026 года (в соответствии с глобальным трендом производства (https://ai-2027.com/research/compute-forecast#section-1-compute-production)), это означает, что ЦЗР имеет 2 млн эквивалентов GPU 2024 года (H100) и потребляет 2 ГВт мощности. У OpenBrain все еще вдвое больше вычислительных ресурсов, чем у DeepCent, а у других американских компаний вместе взятых в 5 раз больше, чем у них. См. раздел распределения вычислительных ресурсов (https://ai-2027.com/supplements/compute-forecast#section-2-compute-distribution) в дополнении по вычислительным ресурсам для получения более подробной информации.

- ↑ Несмотря на продолжающуюся национальную централизацию, DeepCent все еще сталкивается с незначительным, но важным дефицитом вычислительных ресурсов. Помимо того, что у них примерно половина общей вычислительной мощности, Китаю приходится использовать большее общее количество чипов, которые (в среднем) ниже качеством, и гетерогенные GPU (которые не всегда легко эффективно соединить), что создает нагрузку на межчиповые сети. Существуют также различия в программном обеспечении (например, у GPU не от Nvidia нет CUDA) и различия в аппаратных спецификациях, что означает, что их код обучения более сложен, медленен и подвержен сбоям. Достижение высокой утилизации является последующей проблемой, поскольку алгоритмы загрузки данных, планирования, коллективной коммуникации и параллелизма отстают от американских компаний. Однако смягчение этих проблем — это в основном вопрос усилий и тестирования, что делает это отличной задачей для недавно украденного Agent-2, и в течение примерно месяца время безотказной работы китайского проекта и их средняя утилизация ресурсов при обучении и инференсе улучшаются до уровня, лишь незначительно отстающего от США.