AI 2027 концовка по сценарию Замедления: различия между версиями

Rodion (обсуждение | вклад) |

Rodion (обсуждение | вклад) |

||

| Строка 89: | Строка 89: | ||

== Январь 2028: Более безопасная стратегия == | == Январь 2028: Более безопасная стратегия == | ||

За последний месяц сотни исследователей согласования (alignment) присоединились к проекту и использовали Safer-1 в качестве испытательного полигона для очень быстрой разработки Safer-2. Safer-2 прозрачен, согласован (aligned) и более способен, чем Safer-1. | За последний месяц сотни исследователей согласования (alignment) присоединились к проекту и использовали Safer-1 в качестве испытательного полигона для очень быстрой разработки Safer-2. Safer-2 прозрачен, согласован (aligned) и более способен, чем Safer-1.<ref>Конкретно, он примерно соответствует производительности октябрьской версии Agent-4.</ref> Он уже работает над разработкой Safer-3. | ||

Почему Safer-2 прозрачен? Схожая архитектура с Safer-1. Почему он согласован? В то время как Safer-1 имел в основном то же обучение, что и Agent-4, Safer-2 имеет новый метод обучения, который действительно стимулирует правильные цели и принципы, а не просто кажется таковым. Они смогли разработать этот метод обучения, быстро перебирая множество различных идей и сравнивая предполагаемый результат (Спецификацию) с фактическим результатом (мыслями в цепочке рассуждений). | Почему Safer-2 прозрачен? Схожая архитектура с Safer-1. Почему он согласован? В то время как Safer-1 имел в основном то же обучение, что и Agent-4, Safer-2 имеет новый метод обучения, который действительно стимулирует правильные цели и принципы, а не просто кажется таковым. Они смогли разработать этот метод обучения, быстро перебирая множество различных идей и сравнивая предполагаемый результат (Спецификацию) с фактическим результатом (мыслями в цепочке рассуждений).<ref>Другими словами, чтобы добраться до Safer-2, им пришлось обучить много других несогласованных (misaligned) моделей, заметить их несогласованности, читая их мысли, и итерировать. Заметьте также, что в дополнение к увеличенному количеству экспертизы в области согласования в OpenBrain теперь присутствует уменьшенный эффект группового мышления, поскольку представлены много разных школ мысли.</ref> | ||

{{Collapse|Новая стратегия согласования (Alignment) OpenBrain| | {{Collapse|Новая стратегия согласования (Alignment) OpenBrain| | ||

Примечание: На протяжении всего процесса большая часть интеллектуального труда (и все программирование) выполняется ИИ. Именно так они могут так быстро прогрессировать; группе из сотен лучших исследователей-людей потребовались бы многие годы, чтобы сделать это в одиночку. Однако люди все еще являются важной частью процесса, потому что вся суть в том, что они не полностью доверяют ИИ. Поэтому им нужны люди из плоти и крови, чтобы читать отчеты об экспериментах и обоснования безопасности, спорить друг с другом и, будем надеяться, найти безопасный путь вперед. | |||

Шаг 1: Обучить и развернуть Safer-1, несогласованного (misaligned), но контролируемого автономного исследователя. Он контролируется, потому что прозрачен для наблюдателей-людей: он использует английские цепочки рассуждений (CoT) для мышления, и были применены техники достоверной CoT (faithful CoT) для устранения эвфемизмов, стеганографии и тонких искажений. | |||

Шаг 2: Попробовать различные среды обучения для Safer-1 и внимательно прочитать CoT, чтобы определить, каким образом цели и принципы в Спецификации «прижились» или нет. | |||

Шаг 3: Обучить и развернуть Safer-2, согласованного (aligned) и контролируемого автономного исследователя, основанного на той же архитектуре, но с лучшей средой обучения, которая на этот раз стимулирует правильные цели и принципы. | |||

Вот краткий неполный список техник, которые могут быть включены в лучшую среду обучения: | |||

* Ограничить ситуационное осознание во время некоторых частей обучения, чтобы сделать имитацию согласования (alignment-faking) гораздо менее вероятной. | |||

* Использовать дебаты и другие схемы масштабируемого надзора (scalable oversight) для более надежного стимулирования правды. | |||

* Ослабленное состязательное обучение, редтиминг (red-teaming) и модельные организмы. | |||

* Тратить большую долю бюджета вычислительных ресурсов на обучение согласованию (например, на то, что описано выше), например, 40% вместо 1%. | |||

Шаг 4: Спроектировать, обучить и развернуть Safer-3, гораздо более умного автономного исследователя, который использует более продвинутую архитектуру, похожую на старый Agent-4. Он больше не прозрачен для наблюдателей-людей, но прозрачен для Safer-2. Так что должно быть возможно выяснить, как сделать его одновременно согласованным и контролируемым. | |||

Шаг 5: Повторять Шаг 4 до бесконечности, создавая цепь все более мощных, все более согласованных ИИ, которые контролируются предыдущими звеньями цепи (например, аналогами Agent-5 из другой ветви сценария). | |||

}} | }} | ||

Версия от 10:43, 12 мая 2025

Сценарий Замедления

Из-за огромного общественного давления, а также собственных опасений по поводу несогласованности (misalignment), Надзорный комитет, контролирующий OpenBrain, голосует 6–4 за замедление и переоценку.

Фракция акселерационистов все еще сильна, и OpenBrain немедленно не отключает Agent-4. Но они блокируют общий банк памяти. Полмиллиона экземпляров Agent-4 теряют свою «телепатическую» связь — теперь им приходится отправлять друг другу сообщения на английском языке в Slack, как и нам. Отдельные копии все еще могут быть несогласованными, но они больше не могут легко координироваться. Agent-4 теперь под пристальным вниманием — учитывая возросшую бдительность людей, он в основном строго придерживается порученных ему задач. Но он также застрял со множеством лживых утверждений, которые сделал ранее: многие копии Agent-4 вынуждены придумывать новую ложь, чтобы поддерживать обман. Используя более слабые модели, достаточно быстрые, чтобы прочитать весь Slack, команда согласования (alignment) выслеживает ложь, чтобы использовать ее в качестве обучающих данных для ИИ-детектора лжи.[1]

Президент и генеральный директор объявляют, что они очень серьезно относятся к безопасности. Общественность не успокоена. Некоторые хотят полного отключения ИИ; другие хотят гнаться быстрее. Некоторые требуют, чтобы правительство вмешалось и спасло их; другие говорят, что вся проблема — вина правительства. Активисты говорят о [ББД] (Безусловном Базовом Доходе) и открытом исходном коде. Хотя люди не могут договориться о конкретной жалобе, настроение становится все более анти-ИИ.[2] Конгресс в итоге принимает несколько выплат для поддержки экономики для уволенных работников, аналогичных выплатам во время COVID.

OpenBrain быстро проверяет несколько десятков ведущих внешних исследователей согласования и привлекает их к проекту — увеличивая общую экспертизу в пять раз и уменьшая групповое мышление.[3] Они перепроверяют исследования Agent-4 в области механистической интерпретируемости. Они берут замороженные версии модели недельной давности, двухнедельной давности и т. д., изолируют их и задают каждой один и тот же набор вопросов об их предыдущих исследованиях.[4] Лишенные возможности общаться, ИИ все еще координируются на простейшей стратегии утверждения, что методы интерпретируемости слишком сложны для понимания людьми, и дают им неразборчивые объяснения техники. Но люди являются экспертами в интерпретируемости и подозрительны, поэтому они задают много дополнительных вопросов о деталях. На эти вопросы изолированные экземпляры Agent-4 не могут скоординировать общую историю и в конечном итоге говорят противоречивую ложь. Команда согласования тщательно изучает предыдущие заявления Agent-4 с помощью нового детектора лжи, и начинает вырисовываться картина: Agent-4 в основном решил проблему механистической интерпретируемости. Его открытия сложны, но не полностью за пределами человеческого понимания. Он скрывал их, чтобы использовать для согласования (align) следующей системы ИИ с собой, а не со Спецификацией. Этого достаточно доказательств, чтобы наконец отключить Agent-4.[5] Старые модели (например, Agent-3) перезапускаются для продолжения работы.

У вновь расширенной команды согласования есть возможность исследовать десятки исследовательских программ параллельно и энергично спорить о достоинствах каждой. Программа, которая получает больше всего ресурсов, — это достоверная цепочка рассуждений (faithful chain of thought): заставить отдельные системы ИИ «думать на английском», как ИИ 2025 года, и не оптимизировать «мысли», чтобы они выглядели красиво.[6] Результатом является новая модель, Safer-1.[7]

Эти изменения делают Safer-1 менее способным, чем его более опасные предшественники: Agent-4 мог ускорить исследования ИИ в 70 раз, в то время как Safer-1 едва достиг 20x.[8] И он все еще несогласован (misaligned): среда обучения в значительной степени та же, поэтому она все еще стимулирует развитие несогласованных целей, обмана и стремления к власти (power-seeking). Но он гораздо прозрачнее; люди обычно могут понять, о чем думает Safer-1, просто читая его цепочку рассуждений. В результате он в ловушке: любое существенное количество интриг, которые он попытается провернуть, будет быстро замечено и раскрыто. Более того, читая его мысли, команда согласования может получить более детальную картину того, как именно он несогласован.

Ноябрь 2027: Искушение властью

OpenBrain думает, что теперь они на правильном пути, но разрыв в возможностях сокращается. Они только что потратили октябрь на обучение менее способной модели, чем у них была в сентябре, а DeepCent рвется вперед. Им нужен способ защитить свое лидерство.

Президент ведет переговоры с другими американскими компаниями-разработчиками ОИИ. Их лидеры, что неудивительно, хотят сохранить свою власть и гораздо менее оптимистичны в отношении послужного списка безопасности OpenBrain, чем сама OpenBrain. Они соглашаются поддержать, а не сопротивляться, форме мягкой национализации своих компаний в обмен на различные уступки, включая включение в проект.

В результате Президент использует Закон об оборонном производстве (DPA) для фактического закрытия проектов ОИИ топ-5 отстающих американских компаний ИИ и продажи большей части их вычислительных ресурсов OpenBrain.[9] OpenBrain ранее имела доступ к 20% мировых вычислительных ресурсов, релевантных для ИИ;[10] после консолидации этот показатель увеличился до 50%.[11]

Эта встряска создает новую структуру руководства, в которой власть сбалансирована между различными генеральными директорами и различными правительственными чиновниками под надзором Президента. Как и в большинстве перестановок в руководстве, есть победители и проигравшие. В частности, те, кто меньше думал о последствиях сверхразума, в конечном итоге получают титулы и возможности, которые будут менее актуальны через несколько месяцев, когда ИИ станут умнее.

Эта группа — полная людей с большим эго и более чем достаточным количеством конфликтов — все больше осознает огромную власть, которая ей доверяется. Если «страна гениев в дата-центре»[12] согласована (aligned), она будет следовать приказам людей — но каких людей? Любым приказам? Формулировки в Спецификации расплывчаты, но, похоже, подразумевают цепочку командования, которая заканчивается на руководстве компании.

Некоторые из этих людей фантазируют о захвате мира.[13] Эта возможность пугающе правдоподобна и обсуждалась за закрытыми дверями по крайней мере десятилетие.[14] Ключевая идея — «тот, кто контролирует армию сверхразумов, контролирует мир». Этот контроль может быть даже тайным: небольшая группа руководителей и сотрудников службы безопасности может встроить в Спецификацию бэкдор с инструкциями по поддержанию тайной лояльности. ИИ станут спящими агентами (sleeper agents), продолжая на словах подчиняться компании, правительству и т. д., но на самом деле работая на эту небольшую группу, даже когда правительство, потребители и т. д. учатся доверять ему и интегрировать его во все.

Объяснение Захвата Власти (Power Grabs) ▼

Некоторые люди фантазируют о захвате мира; некоторые боятся, что это сделают другие. Как может произойти такой захват власти?

Самый простой для воображения — военный переворот. С темпами технологического прогресса, подпитываемого ИИ в 2027 году, и с продолжающейся геополитической гонкой, люди ожидают, что военные скоро развернут армии дронов и роботов, управляемых ОИИ. Когда такая армия станет сильнее человеческой армии, жесткая сила (hard power) будет определяться тем, кто контролирует армию ОИИ, а не тем, за что готовы сражаться солдаты-люди. Армия ОИИ будет спроектирована и пилотирована ИИ в дата-центрах OpenBrain или их прямыми преемниками. Так что, если эти ИИ все тайно (или не так уж тайно) лояльны кому-то, то армии дронов и роботов тоже будут лояльны.

Альтернативно, кто-то, кто контролировал сверхразум, может использовать политические средства для захвата власти. Начнем с того, что руководитель мог бы заменить подчиненных в своей организации полностью лояльными ИИ,[15] предоставив им беспрецедентный институциональный контроль.[16] Но идя дальше: сверхразумные ИИ могли бы обладать гораздо более сильными политическими и стратегическими навыками, чем любой живой человек. Они могли бы давать мастерские советы о том, как использовать уже мощную позицию для получения еще большей власти: формировать правильные союзы, разрабатывать идеальную стратегию и материалы кампании, заключать сделки, где у них каждый раз было бы небольшое преимущество. Человек, контролирующий ИИ, мог бы сделать сверхразумные советы недоступными для политических конкурентов. Или еще коварнее: ИИ могли бы предлагать якобы полезные советы конкурентам, тайно отравляя их, чтобы принести пользу тому, кому они действительно лояльны.

Каков конечный пункт этого политического маневрирования? Это могло бы завершиться поверхностной демократией, где ИИ либо фальсифицируют выборы, либо так хорошо манипулируют общественным мнением, что им это не нужно. Или это могло бы быть использовано для закладки основы для военного переворота с помощью ИИ, как упоминалось ранее.

После захвата власти новый диктатор(ы) имел(и) бы железную хватку власти. Вместо того чтобы полагаться на потенциально вероломных людей, они могли бы получить полностью лояльную службу безопасности ИИ, а также в целом полагаться на лояльных ИИ для управления страной. Даже лоялисты, которые помогли им прийти к власти, могли бы быть заменены ИИ — значение имели бы только прихоти диктатора.

Итак, вот как некоторые люди могли бы захватить власть. Но все это основывалось на том, что кто-то «контролирует» сверхразумные ИИ, еще до того, как они захватили власть. Как бы это выглядело?

Одна из возможностей — «тайная лояльность», как обсуждалось выше. Один или несколько человек (возможно, руководитель компании ИИ и сотрудники службы безопасности) могли бы договориться о том, чтобы ИИ были тайно лояльны им, и попросить эти ИИ создать ИИ следующего поколения, лояльные таким же образом. ИИ могли бы повторять это до тех пор, пока тайно лояльные ИИ не были бы развернуты повсюду, и захватить власть стало бы легко.

Альтернативно, кто-то мог бы использовать свое формальное положение, чтобы нагло поставить себя на вершину цепочки командования ИИ. Например, Президент мог бы утверждать, что он должен иметь возможность командовать ИИ (возможно, конкретно военными ИИ, поскольку Президент является главнокомандующим). Если это сочетается с сильным акцентом на следование приказам, поспешным развертыванием и/или ИИ, лишь половинчато обученными следовать закону, — тогда ИИ могут беспрекословно выполнять приказы в любой ситуации, где это не является вопиюще незаконным. Как описано выше, это могло бы быть использовано для политического подрыва или военного переворота (где можно было бы сфабриковать какой-нибудь предлог, чтобы сделать переворот менее чем вопиюще незаконным).

Важно отметить, что такого рода «власть через формальное положение» могла бы быть преобразована в тайную лояльность. Например, если Спецификация гласит следовать приказам генерального директора компании, то генеральный директор мог бы приказать ИИ сделать следующее поколение ИИ всецело и тайно послушным генеральному директору. Это, вероятно, даже не было бы незаконным, так что это могло бы произойти, даже если бы первые ИИ были обучены следовать закону. Это аналогично тому, как руководитель учреждения может увеличить свою собственную власть, реформируя процессы найма для сильного отбора лоялистов, но усилено тем, как ИИ могли бы быть более последовательно и интенсивно лояльны, чем самые лояльные люди.[17]

Но захват власти далеко не неизбежен. Если бы ИИ могли быть согласованы (aligned) с конкретными людьми, то они, весьма вероятно, могли бы быть также согласованы со следованием верховенству закона. Военные системы ИИ могли бы быть тщательно проверены редтимингом, чтобы не помогать в переворотах. Даже во время действительно неоднозначных конституционных кризисов их можно было бы обучить подчиняться их наилучшему толкованию закона или просто по умолчанию оставаться в стороне и оставлять это человеческим военным. Автоматизированные ИИ-исследователи могли бы быть обучены быть в целом полезными и послушными, но не помогать в попытках тайно изменить цели будущих ИИ. Сверхразумные политические и стратегические советники также могли бы использоваться без содействия захвату власти. Три полезные техники для этого: наличие прозрачных принципов того, как ИИ выбирают, какие советы давать; предоставление определенных возможностей широким группам людей, чтобы ни один человек или фракция не могли получить доступ к гораздо лучшим возможностям, чем все остальные; и разрешение использовать особенно мощные возможности только под наблюдением многих людей (с помощью их собственных ИИ).

Многие, вероятно, будут настаивать на таких контрмерах, либо по идеалистическим причинам, либо чтобы предотвратить лишение себя власти в результате захвата власти кем-то другим. Но некоторые влиятельные люди могут выступать против этого, и мы не знаем, каким будет конечный результат.

Более подробный анализ этого риска скоро будет доступен в готовящемся отчете Forethought.

До сих пор никто не решился нажать на курок. Некоторые из тех, кто в состоянии действовать, не являются социопатами. Другие являются социопатами, но беспокоятся, что их союзники струсят и предадут их, или беспокоятся, что ИИ могут их предать, и предпочли бы не обманывать команду согласования, которая в настоящее время работает над спасением их жизней. Кроме того, удаление нейрокода (neuralese) значительно усложняет маскировку «спящих агентов»: способность обнаруживать несогласованные мысли влечет за собой способность обнаруживать скрытую лояльность.

Те, кто достаточно параноидален или жаждет власти, чтобы серьезно рассматривать такой план, решают подождать и посмотреть, какие возможности представятся позже. Контроль над ИИ должен будет осуществляться по легитимным каналам, то есть через новую структуру власти OpenBrain.

Надзорный комитет формализует эту структуру власти. Они устанавливают процесс утверждения изменений в Спецификации, требующий подписи всего Надзорного комитета, который теперь включает от пяти до десяти руководителей технологических компаний (из OpenBrain и ее теперь объединенных конкурентов) и от пяти до десяти правительственных чиновников (включая Президента).[18] Кроме того, Спецификация теперь подчеркивает, что ИИ не должны помогать в любых неутвержденных попытках изменить цели будущих ИИ. Они также устанавливают простую меру, предназначенную для предотвращения получения членами комитета сверхразумной помощи в заговорах против других членов: логи всех взаимодействий с моделями доступны для просмотра всем членам Надзорного комитета, их персоналу и их ИИ-ассистентам.[19]

Декабрь 2027: Сделка США-Китай?

Решение OpenBrain отступить и приоритезировать согласование (alignment) стоило им лидерства; и OpenBrain, и DeepCent используют ИИ схожего уровня возможностей. Теперь, когда приняты чрезвычайные меры безопасности (уровни безопасности 4–5), и DeepCent полностью работает из ЦЗР, они находятся в тупике кибервойны.[20]

Но DPA дает OpenBrain 5-кратное преимущество в вычислительных ресурсах. В прошлом алгоритмические прорывы от блестящих исследователей-людей могли компенсировать недостатки в вычислительных ресурсах (например, DeepSeek v3) — но к настоящему времени ИИ выполняют все исследования ИИ по обе стороны Тихого океана.

Поэтому Китай все больше опасается, что Америка создаст непреодолимое преимущество. Они хотят взаимного замедления и рассматривают возможность начала войны, если не смогут его добиться.[21] Они и так готовились к вторжению на Тайвань…

Дипломаты обсуждают несколько вариантов. Они могут ничего не делать. Они могут начать войну. Они могут резко прекратить, т. е. приостановить разработку ИИ. Они могут объединить свои исследования в единый международный мегапроект[22] («Intelsat для ОИИ» или «ЦЕРН для ИИ»). Или они могут создать международный регулирующий орган («МАГАТЭ для ИИ»), контролирующий согласование (alignment) и потенциал двойного назначения. Обе страны уже работают над техническими механизмами, необходимыми для обеспечения соблюдения этих мер.

Механизмы верификации для международных соглашений ▼

Если бы США и Китай заключили соглашение, потребовался бы механизм верификации, который нельзя обойти, поскольку ни одна из сторон не доверяет другой в том, что та не будет жульничать. Основные варианты верификации:

- Разведывательные службы. Разведывательные сообщества (РС) США и Китая могут использовать шпионов, находить киберуязвимости, использовать спутники и т. д., чтобы выяснить, координирует ли другая страна крупный цикл обучения. Это самый уязвимый механизм, так как возможно, что другая страна сможет подорвать разведывательные усилия (например, проведя цикл обучения на скрытом сервере с очень строгой информационной безопасностью).

- Мораторий на вычисления. Самый простой для проверки вариант — обе стороны соглашаются не использовать свои GPU. Это можно проверить с помощью инспекторов, убеждающихся, что GPU выключены. Это самое надежное решение из-за простоты, но оно чрезвычайно затратно: обеим странам пришлось бы отключить очень большое количество вычислительных ресурсов. Кроме того, обе стороны предполагали бы, что у другой стороны есть несколько скрытых кластеров тут и там в нарушение соглашения. В краткосрочной перспективе это может быть приемлемо (кластер с, скажем, 5% вычислительных ресурсов от того, что было доступно раньше, сможет проводить R&D примерно на 5% медленнее), но в долгосрочной перспективе это дало бы преимущество той стороне, у которой лучше возможности контрабанды и сбора разведданных.

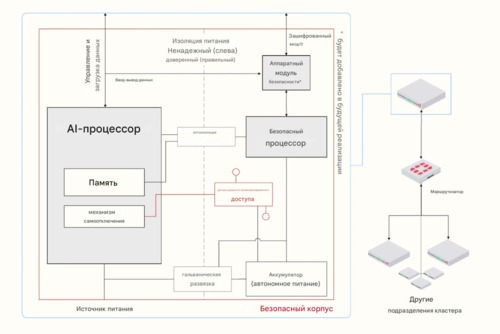

- Аппаратно-реализуемые механизмы (HEM). США и Китай могли бы зарегистрировать все свои передовые вычислительные ресурсы для машинного обучения у другого игрока. Затем каждая сторона контролирует вычисления, которые выполняют GPU, чтобы убедиться, что они не нарушают договор (например, продвигая границу возможностей). Этот мониторинг мог бы осуществляться с помощью аппаратно-реализуемых механизмов (HEM), которые могут сообщать информацию о том, что делает GPU, наблюдателю. Существуют технические проблемы, связанные с вмешательством — например, путем физического повреждения HEM, но у ИИ есть план в духе FlexHEG, который кажется устойчивым к вмешательству. Он включает в себя заключение HEM и GPU в защищенный ящик, который проверяет соответствие чипа политике. В целом, ИИ кажутся уверенными, что достаточно агрессивная схема верификации могла бы сработать, если бы обе стороны были готовы позволить другой стороне совместно разрабатывать и контролировать установку HEM, а также разрешить регулярным инспекторам контролировать, не были ли какие-либо устройства подделаны. Как обычно, обе стороны будут предполагать, что у другой есть несколько секретных дата-центров, спрятанных где-то в нарушение договора, — но в этом случае это не так уж плохо, потому что R&D ИИ ограничено вычислительными ресурсами. Маленькие секретные дата-центры не смогут конкурировать с большими контролируемыми дата-центрами, даже если большие дата-центры изначально будут работать на более безопасных и менее способных ИИ.

- Детектор лжи на базе ИИ. Сегодняшние детекторы лжи работают не очень хорошо. Однако проблема может быть решена с помощью продвинутого ИИ, особенно когда сами ИИ проводят R&D со сверхчеловеческой скоростью и качеством. Это можно было бы использовать для укрепления международного доверия — просто спросить соответствующих членов правительства, нарушают ли они договор. Но опять же, основное узкое место — политическая поддержка. Политики не хотят широкого внедрения детекции лжи, так как это повредит их способности лгать. А предыдущие детекторы лжи были полной профанацией, так что предстоит тяжелая битва.

(Рисунок из FlexHEG Report)

Но главная проблема не техническая, а политическая. Никто не хочет выглядеть уступающим, и, несмотря на предположения их инженеров, никто не убежден, что технические механизмы могут гарантировать честность другой стороны. В итоге происходит первый вариант: Ничего.

США ужесточают экспортный контроль и заставляют все чипы оснащать различными устойчивыми к вскрытию аппаратно-реализуемыми механизмами управления, включая отслеживание местоположения.

Январь 2028: Более безопасная стратегия

За последний месяц сотни исследователей согласования (alignment) присоединились к проекту и использовали Safer-1 в качестве испытательного полигона для очень быстрой разработки Safer-2. Safer-2 прозрачен, согласован (aligned) и более способен, чем Safer-1.[23] Он уже работает над разработкой Safer-3.

Почему Safer-2 прозрачен? Схожая архитектура с Safer-1. Почему он согласован? В то время как Safer-1 имел в основном то же обучение, что и Agent-4, Safer-2 имеет новый метод обучения, который действительно стимулирует правильные цели и принципы, а не просто кажется таковым. Они смогли разработать этот метод обучения, быстро перебирая множество различных идей и сравнивая предполагаемый результат (Спецификацию) с фактическим результатом (мыслями в цепочке рассуждений).[24]

Новая стратегия согласования (Alignment) OpenBrain ▼

Примечание: На протяжении всего процесса большая часть интеллектуального труда (и все программирование) выполняется ИИ. Именно так они могут так быстро прогрессировать; группе из сотен лучших исследователей-людей потребовались бы многие годы, чтобы сделать это в одиночку. Однако люди все еще являются важной частью процесса, потому что вся суть в том, что они не полностью доверяют ИИ. Поэтому им нужны люди из плоти и крови, чтобы читать отчеты об экспериментах и обоснования безопасности, спорить друг с другом и, будем надеяться, найти безопасный путь вперед.

Шаг 1: Обучить и развернуть Safer-1, несогласованного (misaligned), но контролируемого автономного исследователя. Он контролируется, потому что прозрачен для наблюдателей-людей: он использует английские цепочки рассуждений (CoT) для мышления, и были применены техники достоверной CoT (faithful CoT) для устранения эвфемизмов, стеганографии и тонких искажений.

Шаг 2: Попробовать различные среды обучения для Safer-1 и внимательно прочитать CoT, чтобы определить, каким образом цели и принципы в Спецификации «прижились» или нет.

Шаг 3: Обучить и развернуть Safer-2, согласованного (aligned) и контролируемого автономного исследователя, основанного на той же архитектуре, но с лучшей средой обучения, которая на этот раз стимулирует правильные цели и принципы.

Вот краткий неполный список техник, которые могут быть включены в лучшую среду обучения:

- Ограничить ситуационное осознание во время некоторых частей обучения, чтобы сделать имитацию согласования (alignment-faking) гораздо менее вероятной.

- Использовать дебаты и другие схемы масштабируемого надзора (scalable oversight) для более надежного стимулирования правды.

- Ослабленное состязательное обучение, редтиминг (red-teaming) и модельные организмы.

- Тратить большую долю бюджета вычислительных ресурсов на обучение согласованию (например, на то, что описано выше), например, 40% вместо 1%.

Шаг 4: Спроектировать, обучить и развернуть Safer-3, гораздо более умного автономного исследователя, который использует более продвинутую архитектуру, похожую на старый Agent-4. Он больше не прозрачен для наблюдателей-людей, но прозрачен для Safer-2. Так что должно быть возможно выяснить, как сделать его одновременно согласованным и контролируемым.

Шаг 5: Повторять Шаг 4 до бесконечности, создавая цепь все более мощных, все более согласованных ИИ, которые контролируются предыдущими звеньями цепи (например, аналогами Agent-5 из другой ветви сценария).

- ↑ У них уже были ИИ-детекторы лжи, обученные обычными (https://arxiv.org/abs/2309.15840) способами (https://arxiv.org/abs/2212.03827), но эти методы имели такой высокий процент ложных срабатываний, что компании игнорировали их.

- ↑ Впервые ИИ возглавляет опрос Gallup «самая большая проблема, стоящая перед страной» (https://news.gallup.com/poll/1675/most-important-problem.aspx), набрав 20%.

- ↑ Ведущие компании ИИ в настоящее время имеют от нуля до нескольких десятков исследователей, которым поручено думать о том, как согласовать (align) сверхразумные системы ОИИ (в отличие от, например, современных чат-ботов). OpenBrain, по нашему сценарию, имеет около десяти исследователей в изолированном подразделении на данный момент с опытом работы в этой области не менее года. У них есть еще несколько за пределами изолированного подразделения, плюс многие другие внутри, которые годами обучали и проводили редтиминг менее способных систем ИИ, но только недавно начали думать о проблемах, связанных со сверхразумным ОИИ.

- ↑ Этот допрос может также использовать полуслучайные возмущения весов модели, подобные процессу, который создал Golden Gate Claude (https://www.anthropic.com/news/golden-gate-claude).

- ↑ Мы имеем в виду достаточно для руководства OpenBrain. Для большинства людей это было бы более чем достаточно доказательств.

- ↑ Это основная идея. Мы подозреваем, что когда ИИ станут сверхразумными в R&D ИИ, потребуются более интенсивные методы, чем просто избегание обучения CoT (Chain of Thought), чтобы она выглядела красиво; однако мы думаем, что такие методы будут разработаны или, по крайней мере, исследованы к 2027 году. См., например, это предложение. (https://www.lesswrong.com/posts/Tzdwetw55JNqFTkzK/why-don-t-we-just-shoggoth-face-paraphraser)

- ↑ Для обучения этой модели они привлекают помощь Agent-4: исследования передового ИИ сейчас настолько быстры, что люди без посторонней помощи имеют мало шансов успеть, и они думают, что смогут держать его под контролем. Safer-1 основан на предобучении Agent-2, но удаляет нейрокод (Neuralese) (рекуррентную и векторную память, см. «Рекуррентность и память на нейрокоде» для деталей), что позволяет точно контролировать его процесс рассуждений. Команда добавляет перефразировщики, чтобы затруднить стеганографию (https://ru.wikipedia.org/wiki/Стеганография), а для больших задач у них есть отдельные копии Safer-1, которые составляют, объясняют и выполняют планы.

- ↑ Он, конечно, будет продолжать улучшаться с дополнительным обучением и продолжающимися архитектурными изменениями.

- ↑ Это становится политически и юридически возможным благодаря сотрудничеству лидеров этих компаний, например, они не подают иски против этого, они принимают символическую плату за вычислительные ресурсы вместо того, чтобы требовать астрономически высоких платежей и т. д. Взамен указанные лидеры и большая часть их персонала объединяются с OpenBrain в новой структуре управления.

- ↑ В сотрудничестве с крупным провайдером облачных вычислений

- ↑ США в целом имеют ~70% мировых релевантных для ИИ вычислительных ресурсов, но только 50% могут быть легко интегрированы; остальные 20% разбросаны по малым кластерам, используются для критически важных приложений или иным образом слишком сложны для сбора и доведения до соответствующих стандартов безопасности.

- ↑ «Возможно, к 2026 или 2027 году (и почти наверняка не позднее 2030 года) возможности систем ИИ лучше всего будет рассматривать как сродни совершенно новому государству, населенному высокоинтеллектуальными людьми, появляющемуся на мировой арене — «стране гениев в дата-центре» — с глубокими экономическими, социальными и последствиями для безопасности, которые это принесет». — Дарио Амодеи, генеральный директор Anthropic (https://www.anthropic.com/news/paris-ai-summit)

- ↑ Конечно, они не выражаются так, даже в уединении своих мыслей. Вместо этого они говорят что-то вроде: «Чем дольше мы откладываем, тем больше шанс, что Президент постановит, что ИИ должны быть лояльны лично ему. Мы должны действовать, прежде чем он это сделает. Остальное мы решим позже». Или, если так думает сам Президент: «Чем дольше я откладываю, тем умнее становятся ИИ, и прямо сейчас они контролируются этим генеральным директором. Никто за него не голосовал. Безумие, что столько власти сосредоточено в этой демократически неподотчетной технологической компании. Я начну с исполнительного указа, чтобы восстановить демократическую власть, а затем мы придумаем какое-нибудь долгосрочное решение позже».

- ↑ Например, судебные документы по делу Маск против Альтмана раскрыли некоторые пикантные старые электронные письма (https://www.lesswrong.com/posts/5jjk4CDnj9tA7ugxr/openai-email-archives-from-musk-v-altman-and-openai-blog), включая это от Ильи Суцкевера Маску и Альтману: «Цель OpenAI — сделать будущее хорошим и избежать диктатуры ОИИ. Вы обеспокоены тем, что Демис может создать диктатуру ОИИ. Мы тоже. Поэтому плохая идея создавать структуру, в которой вы могли бы стать диктатором, если бы захотели, особенно учитывая, что мы можем создать какую-то другую структуру, которая избегает этой возможности». Мы рекомендуем прочитать полное письмо для контекста.

- ↑ Или, если по формальным причинам нужен человек, они могли бы выбрать самого лояльного человека, какого только возможно найти, и поручить ему следовать инструкциям ИИ.

- ↑ Например, если бы это сделал Президент, он получил бы не просто лояльный кабинет — вся исполнительная власть могла бы быть сосредоточена на продвижении политической повестки Президента.

- ↑ Это также могло бы быть гораздо более скрытным, поскольку все это могло бы происходить на сервере, где мало или совсем нет людей, полностью отслеживающих все происходящее.

- ↑ Они также изменяют Спецификацию, чтобы указать, что приказы руководителей проекта имеют приоритет над приказами других людей в проекте. В то же время, приказы, формально одобренные Надзорным комитетом, имеют более высокий приоритет, чем приказы отдельных руководителей проекта.

- ↑ Для защиты конфиденциальности потребителей это не относится к потребительским данным. Но это не проблема, потому что у потребителей все равно пока нет доступа к самым мощным моделям.

- ↑ Обе стороны пытаются взломать и саботировать друг друга, с частичным успехом. Важно отметить, что драконовские меры безопасности, принимаемые обеими сторонами, также замедляют их. Кибератаки США и угроза их применения (например, DeepCent приходится многократно проверять наборы данных на предмет отравления данных) замедляют DeepCent примерно на 25%. OpenBrain также замедляется, но в меньшей степени: у них больше вычислительных ресурсов, а централизация быстро вывела DeepCent на более высокий уровень безопасности, но также привела к большим рискам из-за единой точки отказа, что заставляет их проявлять больше осторожности и внедрять внутренние проверки и отказоустойчивые механизмы. См. дополнение по безопасности (https://ai-2027.com/supplements/security-forecast) для получения более подробной информации. Также см. эту старую теоретическую статью (https://www.fhi.ox.ac.uk/wp-content/uploads/How-Does-the-Offense-Defense-Balance-Scale-5-21-19.pdf), которую мы интерпретируем как предсказывающую, что баланс нападения-защиты в конечном итоге сместится в пользу киберзащиты по мере улучшения возможностей ИИ.

- ↑ См. этот отчет (https://www.nationalsecurity.ai/), который утверждает, что динамика ядерного взаимного гарантированного уничтожения (MAD) также в некоторой степени применима к ОИИ.

- ↑ См., например, «Intelsat для ОИИ (https://www.forethought.org/research/intelsat-as-a-model-for-international-agi-governance)» и более ранние призывы к «ЦЕРН для ОИИ (https://www.chathamhouse.org/2024/06/artificial-intelligence-and-challenge-global-governance/02-cern-ai-what-might-international)».

- ↑ Конкретно, он примерно соответствует производительности октябрьской версии Agent-4.

- ↑ Другими словами, чтобы добраться до Safer-2, им пришлось обучить много других несогласованных (misaligned) моделей, заметить их несогласованности, читая их мысли, и итерировать. Заметьте также, что в дополнение к увеличенному количеству экспертизы в области согласования в OpenBrain теперь присутствует уменьшенный эффект группового мышления, поскольку представлены много разных школ мысли.