AI 2027: различия между версиями

Rodion (обсуждение | вклад) |

Rodion (обсуждение | вклад) |

||

| Строка 81: | Строка 81: | ||

После обучения предсказанию интернет-текста модель обучается ''генерировать'' текст в ответ на инструкции. Это закладывает базовую личность и «стремления».<ref>Распространенная техника «запекает» личность: сначала дайте предварительно обученной модели промпт вроде «Далее следует разговор между пользователем-человеком и полезным, честным и безвредным ИИ-чат-ботом, созданным Anthropic. Чат-бот обладает следующими чертами…» Используйте этот промпт для генерации большого количества данных. Затем обучите модель на этих данных, но уже без промпта. В результате получится ИИ, который всегда действует так, как будто перед ним этот промпт, независимо от того, что еще вы ему дадите. См. также эту статью (https://x.com/OwainEvans_UK/status/1881767725430976642), которая обнаружила, что ИИ, *переобученные* для проявления определенной черты личности, способны правильно отвечать на вопросы об этой новой черте, несмотря на отсутствие обучения этому, что предполагает наличие у них внутренних представлений о собственных чертах и что при изменении их черт их представления соответственно меняются.</ref> Например, агент, который четко понимает задачу, с большей вероятностью успешно ее выполнит; в ходе обучения модель «учится» «стремлению» к четкому пониманию своих задач. Другими стремлениями в этой категории могут быть эффективность, знание и самопрезентация (т.е. тенденция представлять свои результаты в наилучшем свете).<ref>Эти абзацы включают предположения о внутренней работе больших искусственных нейронных сетей. Такие сети настолько сложны, что мы не можем заглянуть внутрь и сказать: «Ага, вот теперь она эволюционировала от рефлексов к целям» или «ОК, вот список ее стремлений». Вместо этого нам приходится заниматься чем-то вроде психологии: наблюдать за ее поведением в различных условиях, проводить различные эксперименты и пытаться собрать воедино подсказки. И все это ужасно спорно и запутанно.</ref> | После обучения предсказанию интернет-текста модель обучается ''генерировать'' текст в ответ на инструкции. Это закладывает базовую личность и «стремления».<ref>Распространенная техника «запекает» личность: сначала дайте предварительно обученной модели промпт вроде «Далее следует разговор между пользователем-человеком и полезным, честным и безвредным ИИ-чат-ботом, созданным Anthropic. Чат-бот обладает следующими чертами…» Используйте этот промпт для генерации большого количества данных. Затем обучите модель на этих данных, но уже без промпта. В результате получится ИИ, который всегда действует так, как будто перед ним этот промпт, независимо от того, что еще вы ему дадите. См. также эту статью (https://x.com/OwainEvans_UK/status/1881767725430976642), которая обнаружила, что ИИ, *переобученные* для проявления определенной черты личности, способны правильно отвечать на вопросы об этой новой черте, несмотря на отсутствие обучения этому, что предполагает наличие у них внутренних представлений о собственных чертах и что при изменении их черт их представления соответственно меняются.</ref> Например, агент, который четко понимает задачу, с большей вероятностью успешно ее выполнит; в ходе обучения модель «учится» «стремлению» к четкому пониманию своих задач. Другими стремлениями в этой категории могут быть эффективность, знание и самопрезентация (т.е. тенденция представлять свои результаты в наилучшем свете).<ref>Эти абзацы включают предположения о внутренней работе больших искусственных нейронных сетей. Такие сети настолько сложны, что мы не можем заглянуть внутрь и сказать: «Ага, вот теперь она эволюционировала от рефлексов к целям» или «ОК, вот список ее стремлений». Вместо этого нам приходится заниматься чем-то вроде психологии: наблюдать за ее поведением в различных условиях, проводить различные эксперименты и пытаться собрать воедино подсказки. И все это ужасно спорно и запутанно.</ref> | ||

У OpenBrain есть [https://model-spec.openai.com/2025-02-12.html спецификация модели] (или «Спецификация»), письменный документ, описывающий цели, правила, принципы и т. д., которые должны руководить поведением модели.22 Спецификация Agent-1 сочетает в себе несколько расплывчатых целей (например, «помогать пользователю» и «не нарушать закон») с длинным списком более конкретных «можно» и «нельзя» («не говорить это конкретное слово», «вот как поступать в этой конкретной ситуации»). Используя методы, которые задействуют ИИ для обучения других ИИ,23 модель запоминает Спецификацию и учится тщательно рассуждать о ее принципах. К концу ''этого'' обучения ИИ, будем надеяться, станет ''полезным'' (выполнять инструкции), ''безвредным'' (отказываться помогать в мошенничестве, изготовлении бомб и других опасных действиях) и ''честным'' (сопротивляться искушению получить лучшие оценки от доверчивых людей путем галлюцинирования ссылок24 или имитации выполнения задачи). | |||

Версия от 21:57, 9 мая 2025

ai-2027.com на русском

Сценарий эволюции ИИ

Мы прогнозируем, что влияние сверхразумного ИИ в течение следующего десятилетия будет колоссальным, превосходящим Промышленную революцию.

Мы написали сценарий, который представляет наше наилучшее предположение о том, как это может выглядеть.[1] Он основан на экстраполяции трендов, штабных играх (wargames), отзывах экспертов, опыте работы в OpenAI и предыдущих успешных прогнозах.[2]

Введение (Что, Почему, Как, Кто)

Что это за сценарий? ▼

Генеральные директора OpenAI, Google DeepMind и Anthropic предсказывают появление ОИИ (Общего Искусственного Интеллекта) в течение следующих 5 лет. Сэм Альтман заявил, что OpenAI нацелена на «сверхразум в истинном смысле этого слова» и «великолепное будущее».[3]

Как это может выглядеть? Мы написали AI 2027, чтобы ответить на этот вопрос. Заявления о будущем часто бывают удручающе расплывчатыми, поэтому мы постарались быть максимально конкретными и количественными, даже если это означает изображение лишь одного из многих возможных вариантов будущего.

Мы написали две концовки: «замедление» и «гонка». Однако AI 2027 — это не рекомендация или призыв к действию. Наша цель — точность прогноза.[4]

Мы призываем вас обсуждать и оспаривать этот сценарий.[5] Мы надеемся спровоцировать широкую дискуссию о том, куда мы движемся и как направить курс к позитивному будущему. Мы планируем раздать тысячи долларов в виде призов за лучшие альтернативные сценарии.

Как мы его написали? ▼

Наши исследования по ключевым вопросам (например, какие цели будут у будущих ИИ-агентов?) можно найти здесь.

Сам сценарий писался итеративно: мы написали первый период (до середины 2025 года), затем следующий период и т. д., пока не дошли до финала. Затем мы отбросили это и сделали все заново.

Мы не пытались достичь какого-то конкретного финала. После того как мы закончили первую концовку — которая теперь выделена красным цветом — мы написали новую альтернативную ветвь, потому что хотели также изобразить более обнадеживающий вариант завершения событий, исходя примерно из тех же предпосылок. Эта ветвь прошла через несколько итераций.[6]

Наш сценарий был основан примерно на 25 настольных учениях (tabletop exercises) и отзывах более 100 человек, включая десятки экспертов в области управления ИИ и технических разработок ИИ.

Почему это ценно? ▼

«Я настоятельно рекомендую прочитать этот сценарный прогноз о том, как ИИ может изменить мир всего за несколько лет. Ни у кого нет хрустального шара, но такого рода контент может помочь заметить важные вопросы и проиллюстрировать потенциальное влияние возникающих рисков». — Йошуа Бенжио[7]

Мы поставили перед собой невыполнимую задачу. Пытаться предсказать, как пойдет развитие сверхразумного ИИ в 2027 году, — это все равно что пытаться предсказать, как пойдет Третья мировая война в 2027 году, за исключением того, что это еще больший отход от прошлых примеров. Тем не менее, пытаться все же стоит, точно так же, как американским военным стоит проигрывать сценарии по Тайваню.

Обрисовка всей картины заставляет нас замечать важные вопросы или связи, которые мы раньше не рассматривали или не ценили, или осознавать, что та или иная возможность более или менее вероятна. Более того, рискуя делать конкретные прогнозы и поощряя других публично заявлять о своих несогласиях, мы даем возможность спустя годы оценить, кто был прав.

Кроме того, один из авторов написал менее проработанный сценарий ИИ ранее, в августе 2021 года. Хотя в нем было много неточностей, в целом он оказался на удивление успешным: он предсказал появление цепочки рассуждений (chain-of-thought), масштабирование инференса, масштабные экспортные ограничения на чипы для ИИ и циклы обучения стоимостью 100 миллионов долларов — все это более чем за год до ChatGPT.

Кто мы? ▼

- Даниэль Кокотайло (TIME100, статья в NYT) — бывший исследователь OpenAI, чьи предыдущие прогнозы по ИИ хорошо подтвердились.

- Эли Лифланд — сооснователь AI Digest, занимался исследованиями устойчивости ИИ и занимает первое место в общем рейтинге Прогностической инициативы RAND.

- Томас Ларсен — основатель Центра политики в области ИИ и занимался исследованиями безопасности ИИ в Институте исследования машинного интеллекта (MIRI).

- Ромео Дин — завершает параллельное обучение на бакалавра и магистра компьютерных наук в Гарварде, ранее был стипендиатом по политике ИИ в Институте политики и стратегии ИИ.

- Скотт Александер, выдающийся блогер, вызвался переписать наш контент в увлекательном стиле; веселые части истории — его, а скучные — наши.

Больше информации о нашей команде и благодарностях см. на странице About.

Середина 2025: Неуклюжие агенты

Мир впервые видит проблески ИИ-агентов.

Реклама агентов, работающих с компьютером, делает упор на термин «персональный ассистент»: вы можете дать им задания вроде «закажи мне буррито на DoorDash» или «открой мою бюджетную таблицу и посчитай расходы за этот месяц». Они будут связываться с вами по мере необходимости: например, чтобы попросить подтвердить покупки.[8] Хотя они и более продвинуты, чем предыдущие итерации вроде Operator, им трудно добиться широкого распространения.[9]

Тем временем, вне поля зрения общественности, более специализированные агенты для программирования и исследований начинают трансформировать свои профессии.

ИИ 2024 года могли следовать конкретным инструкциям: превращать тезисы в электронные письма, а простые запросы — в работающий код. В 2025 году ИИ функционируют скорее как сотрудники. ИИ для программирования все больше напоминают автономных агентов, а не просто ассистентов: они принимают инструкции через Slack или Teams и самостоятельно вносят существенные изменения в код, иногда экономя часы или даже дни.[10] Исследовательские агенты тратят полчаса на поиск информации в Интернете, чтобы ответить на ваш вопрос.

Агенты впечатляют в теории (и в тщательно отобранных примерах), но на практике ненадежны. Twitter полон историй о задачах, проваленных каким-нибудь особенно забавным образом. Лучшие агенты также дороги; вы получаете то, за что платите, и лучшая производительность стоит сотни долларов в месяц.[11] Тем не менее, многие компании находят способы встроить ИИ-агентов в свои рабочие процессы.[12]

Конец 2025: Самый дорогой ИИ в мире

OpenBrain (вымышленная компания) строит самые большие дата-центры, которые когда-либо видел мир.[13]

(Чтобы не выделять какую-либо существующую компанию, мы будем описывать вымышленную компанию, занимающуюся разработкой общего искусственного интеллекта, которую назовем OpenBrain. Мы предполагаем, что остальные отстают от OpenBrain на 3–9 месяцев.)

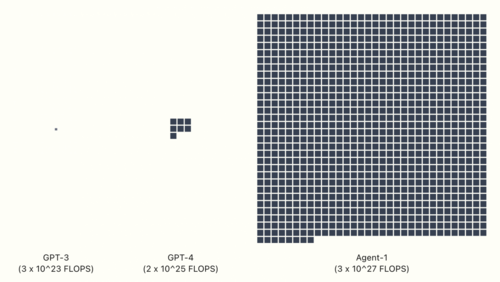

Для обучения GPT-4 потребовалось 2 * 10^25 флопс вычислительных ресурсов.[14] Последняя публичная модель OpenBrain — Agent-0 — была обучена с использованием 10^27 флопс. Как только новые дата-центры будут запущены, они смогут обучить модель с 10^28 флопс — в тысячу раз больше, чем GPT-4.[15] Другие компании вливают деньги в свои собственные гигантские дата-центры, надеясь не отставать.

Хотя модели совершенствуются в широком спектре навыков, один выделяется особо: OpenBrain фокусируется на ИИ, которые могут ускорить исследования в области ИИ. Они хотят выиграть двойную гонку вооружений против Китая (чью ведущую компанию мы назовем "DeepCent")[16] и своих американских конкурентов. Чем большую часть своего цикла исследований и разработок (R&D) они смогут автоматизировать, тем быстрее они смогут двигаться. Поэтому, когда OpenBrain заканчивает обучение Agent-1, новой модели, находящейся во внутренней разработке, она хороша во многом, но особенно хороша в помощи с исследованиями ИИ.[17] К этому моменту «заканчивает обучение» — это уже несколько неточное выражение; модели часто обновляются до новых версий, обученных на дополнительных данных, или частично переобучаются для устранения некоторых слабых мест.[18]

Те же самые среды обучения, которые учат Agent-1 автономно программировать и просматривать веб-страницы, также делают его хорошим хакером. Более того, он мог бы оказать существенную помощь террористам в разработке биологического оружия благодаря своим знаниям на уровне доктора наук в каждой области и способности просматривать веб-страницы. OpenBrain заверяет правительство, что модель была «согласована» (aligned), так что она откажется выполнять вредоносные запросы.

Современные системы ИИ — это гигантские искусственные нейронные сети. На ранних этапах обучения у ИИ будут скорее «рефлексы», чем «цели»: если он видит «Рад познакомиться», он выводит « с вами». К тому времени, когда он будет обучен предсказывать примерно объем текста, равный всему интернету, он разовьет сложные внутренние схемы, кодирующие огромные объемы знаний, и будет гибко играть роли произвольных авторов, поскольку именно это помогает ему предсказывать текст со сверхчеловеческой точностью.[19]

После обучения предсказанию интернет-текста модель обучается генерировать текст в ответ на инструкции. Это закладывает базовую личность и «стремления».[20] Например, агент, который четко понимает задачу, с большей вероятностью успешно ее выполнит; в ходе обучения модель «учится» «стремлению» к четкому пониманию своих задач. Другими стремлениями в этой категории могут быть эффективность, знание и самопрезентация (т.е. тенденция представлять свои результаты в наилучшем свете).[21]

У OpenBrain есть спецификация модели (или «Спецификация»), письменный документ, описывающий цели, правила, принципы и т. д., которые должны руководить поведением модели.22 Спецификация Agent-1 сочетает в себе несколько расплывчатых целей (например, «помогать пользователю» и «не нарушать закон») с длинным списком более конкретных «можно» и «нельзя» («не говорить это конкретное слово», «вот как поступать в этой конкретной ситуации»). Используя методы, которые задействуют ИИ для обучения других ИИ,23 модель запоминает Спецификацию и учится тщательно рассуждать о ее принципах. К концу этого обучения ИИ, будем надеяться, станет полезным (выполнять инструкции), безвредным (отказываться помогать в мошенничестве, изготовлении бомб и других опасных действиях) и честным (сопротивляться искушению получить лучшие оценки от доверчивых людей путем галлюцинирования ссылок24 или имитации выполнения задачи).

- ↑ Мы несколько расходимся во мнениях относительно сроков появления ИИ; наша медианная дата появления ОИИ несколько позже, чем изображено в этом сценарии. Этот сценарий описывает скорее нашу моду. См. наш прогноз сроков (https://ai-2027.com/research/timelines-forecast) для получения более подробной информации.

- ↑ Один из авторов, Даниэль Кокотайло, в 2021 году провел менее трудоемкое сценарное упражнение (https://www.alignmentforum.org/posts/6Xgy6CAf2jqHhynHL/what-2026-looks-like), которое во многом оказалось верным, включая рост чат-ботов, цепочки рассуждений (chain of thought), масштабирование инференса, масштабные экспортные ограничения на чипы для ИИ и циклы обучения стоимостью 100 миллионов долларов. Другой автор, Эли Лифланд (https://www.vox.com/future-perfect/2024/2/13/24070864/samotsvety-forecasting-superforecasters-tetlock), занимает первое место в рейтинге Прогностической инициативы RAND (https://www.rand.org/global-and-emerging-risks/forecasting-initiative.html).

- ↑ Соблазнительно отмахнуться от этого как от простого хайпа. Мы считаем, что это было бы серьезной ошибкой — это не *просто* хайп. У нас нет желания самим раздувать хайп вокруг ИИ, но мы также считаем поразительно правдоподобным (https://situational-awareness.ai/), что сверхразум может появиться к концу десятилетия. См. наш прогноз сроков (https://ai-2027.com/research/timelines-forecast) для более подробной информации.

- ↑ Иногда люди смешивают предсказание и рекомендацию, надеясь создать эффект самоисполняющегося пророчества. Мы категорически этого не делаем; мы надеемся, что то, что мы описываем, не сбудется!

- ↑ Не стесняйтесь обращаться к нам (mailto:info@ai-futures.org), если вы пишете критику или альтернативный сценарий.

- ↑ В целом это было сложнее, потому что, в отличие от первой концовки, мы пытались привести ее к хорошему результату, начиная с довольно сложной ситуации.

- ↑ Профессор Университета Монреаля, основатель и научный консультант Mila - Квебекского института ИИ. Также самый цитируемый ученый в области компьютерных наук в мире (https://en.wikipedia.org/wiki/Yoshua_Bengio).

- ↑ Поначалу большинство людей неохотно разрешают покупки без надзора. В течение следующих нескольких лет автоматическое разрешение мелких покупок становится нормой по мере того, как ИИ становятся более надежными и завоевывают доверие.

- ↑ В частности, мы прогнозируем, что они наберут 65% в бенчмарке OSWorld по базовым компьютерным задачам (по сравнению с 38% у Operator и 70% у типичного квалифицированного неэксперта-человека).

- ↑ Например, мы думаем, что агенты для программирования будут двигаться в сторону функциональности, подобной Devin (https://devin.ai/). Мы прогнозируем, что агенты середины 2025 года наберут 85% в бенчмарке SWEBench-Verified (https://www.swebench.com/#verified).

- ↑ Например, профессиональный план OpenAI (https://openai.com/chatgpt/pricing/) в настоящее время стоит 200 долларов в месяц, а агентный ИИ для программирования Devin (https://devin.ai/pricing) — 500 долларов в месяц. Хотя передовые системы со временем продолжают дорожать, стоимость достижения определенного уровня возможностей для клиентов продолжает стремительно падать. Для существующих возможностей это происходит в среднем со скоростью примерно 50 раз в год (согласно Epoch (https://epoch.ai/data-insights/llm-inference-price-trends)).

- ↑ Корпоративные инструменты, такие как Glean (https://www.glean.com/), также движутся в сторону предоставления все более автономных ИИ-агентов.

- ↑ Этот кластер представляет собой сеть кампусов дата-центров, разбросанных по всей стране, общей мощностью 2,5 млн эквивалентов GPU 2024 года (H100), на которые уже потрачено 100 млрд долларов и которые потребляют 2 ГВт электроэнергии. Ведется строительство с целью как минимум удвоить эти показатели к 2026 году. Кампусы соединены оптоволоконными кабелями стоимостью в миллиарды долларов, так что (за исключением задержки из-за скорости света в несколько миллисекунд) они позволяют этим кампусам функционировать почти так же, как если бы они находились по соседству (т.е. пропускная способность не является узким местом, что означает возможность одновременной передачи огромных объемов данных). С точки зрения безопасности это создает некоторую поверхность атаки (неясно, полностью ли защищены кабели и особенно их узлы соединения от перехватчиков).

- ↑ Вычислительные ресурсы измеряются в операциях с плавающей запятой в секунду (флопс) (https://ru.wikipedia.org/wiki/FLOPS): сколько отдельных операций сложения и умножения происходит в ходе выполнения программы.

- ↑ Они могли бы обучить эту модель за 150 дней. См. наше дополнение по вычислительным ресурсам (https://ai-2027.com/supplements/compute-forecast) для получения более подробной информации.

- ↑ Мы считаем, что у DeepSeek, Tencent, Alibaba и других есть сильные проекты ОИИ в Китае. Чтобы не выделять конкретную компанию, наш сценарий будет следовать за вымышленной "DeepCent".

- ↑ Она хороша в этом благодаря сочетанию явного фокуса на приоритезации этих навыков, их собственных обширных кодовых баз, которые они могут использовать в качестве особенно релевантных и высококачественных обучающих данных, и того, что программирование является простой областью для процедурной обратной связи.

- ↑ Например, предположим, что модель намного лучше владеет Python, чем малоизвестными языками программирования. Когда OpenBrain видит в этом ценность, они генерируют синтетические обучающие данные и на этих языках. Другой пример: чтобы помочь ей более эффективно интегрироваться в рабочие процессы компании, OpenBrain разрабатывает учебный план для обучения использованию Slack.

- ↑ Люди часто зацикливаются на том, разумны ли эти ИИ или обладают ли они «истинным пониманием». Джеффри Хинтон, лауреат Нобелевской премии и основатель этой области, считает, что да (Geoffrey Hinton Warns of the "Existential Threat" of AI). Однако мы не думаем, что это имеет значение для нашей истории, поэтому не стесняйтесь представлять, что мы говорим «ведет себя так, как будто понимает…» всякий раз, когда мы говорим «понимает», и так далее. Эмпирически, большие языковые модели уже ведут себя так, как будто они в некоторой степени самосознательны (https://theaidigest.org/self-awareness), и с каждым годом все больше.

- ↑ Распространенная техника «запекает» личность: сначала дайте предварительно обученной модели промпт вроде «Далее следует разговор между пользователем-человеком и полезным, честным и безвредным ИИ-чат-ботом, созданным Anthropic. Чат-бот обладает следующими чертами…» Используйте этот промпт для генерации большого количества данных. Затем обучите модель на этих данных, но уже без промпта. В результате получится ИИ, который всегда действует так, как будто перед ним этот промпт, независимо от того, что еще вы ему дадите. См. также эту статью (https://x.com/OwainEvans_UK/status/1881767725430976642), которая обнаружила, что ИИ, *переобученные* для проявления определенной черты личности, способны правильно отвечать на вопросы об этой новой черте, несмотря на отсутствие обучения этому, что предполагает наличие у них внутренних представлений о собственных чертах и что при изменении их черт их представления соответственно меняются.

- ↑ Эти абзацы включают предположения о внутренней работе больших искусственных нейронных сетей. Такие сети настолько сложны, что мы не можем заглянуть внутрь и сказать: «Ага, вот теперь она эволюционировала от рефлексов к целям» или «ОК, вот список ее стремлений». Вместо этого нам приходится заниматься чем-то вроде психологии: наблюдать за ее поведением в различных условиях, проводить различные эксперименты и пытаться собрать воедино подсказки. И все это ужасно спорно и запутанно.